Meta intensifica la corsa all’AGI con investimenti strategici

L’alba del 16 giugno 2025 segna un momento cruciale nella competizione per il dominio dell’intelligenza artificiale. Meta, sotto la guida di Mark Zuckerberg, sta accelerando i suoi sforzi per sviluppare una super intelligenza artificiale (AGI), un obiettivo che la pone in diretta competizione con colossi del calibro di Google, OpenAI e Apple. Questa mossa strategica non è solo una questione di prestigio tecnologico, ma una necessità per Meta di proteggere la propria posizione nel mercato e anticipare potenziali minacce.

La genesi del “Gruppo Superintelligenza”

La strategia di Meta si concretizza nella creazione di un team d’élite, soprannominato “Gruppo Superintelligenza”, composto da circa 50 esperti selezionati personalmente da Zuckerberg. Questi incontri esclusivi, tenuti nelle residenze private del CEO in California, testimoniano l’importanza che Zuckerberg attribuisce a questo progetto. L’obiettivo è chiaro: sviluppare modelli di intelligenza artificiale con capacità che superino di gran lunga quelle umane, avvicinandosi all’AGI. Il quartier generale del team sarà strategicamente posizionato vicino agli uffici di Meta, facilitando la collaborazione e l’integrazione. Il finanziamento di questa ambiziosa impresa sarà sostenuto principalmente dalle entrate pubblicitarie di Meta, dimostrando l’impegno finanziario dell’azienda verso l’innovazione nell’IA.

L’acquisizione strategica di Scale AI

Parallelamente alla formazione del “Gruppo Superintelligenza”, Meta ha investito massicciamente in Scale AI, una startup specializzata nell’etichettatura dei dati, un processo cruciale per l’addestramento efficace dei modelli di IA. L’acquisizione del 49% di Scale AI per 14,3 miliardi di dollari rappresenta una mossa audace che conferisce a Meta un vantaggio competitivo significativo. Alexandr Wang, il giovane e visionario CEO di Scale AI, assumerà un ruolo chiave nella guida del Superintelligence Lab di Meta, portando con sé l’esperienza e le competenze necessarie per sviluppare modelli di intelligenza artificiale generale. Questa partnership strategica non solo fornisce a Meta l’accesso a una vasta quantità di dati etichettati, ma le consente anche di controllare la “pipeline” dei dati, influenzando la semantica e la narrazione dell’IA.

La competizione e la visione di Zuckerberg

La decisione di Zuckerberg di investire massicciamente nell’AGI è motivata dalla volontà di superare la concorrenza e di evitare che Meta venga lasciata indietro nella corsa all’IA. Il tiepido successo di Llama 4, il modello di linguaggio sviluppato internamente da Meta, ha acuito la frustrazione di Zuckerberg e lo ha spinto a cercare nuove soluzioni. L’obiettivo è chiaro: sviluppare un’AGI in grado di imparare, comprendere e applicare la conoscenza come un essere umano, integrando questa capacità nella suite di prodotti Meta, dalle piattaforme di social media agli occhiali Ray-Ban con l’IA. Zuckerberg è determinato a fare dell’IA una priorità assoluta per l’azienda, riorganizzando persino gli uffici per avere il team di super intelligenza AI vicino alla sua scrivania.

Implicazioni etiche e geopolitiche

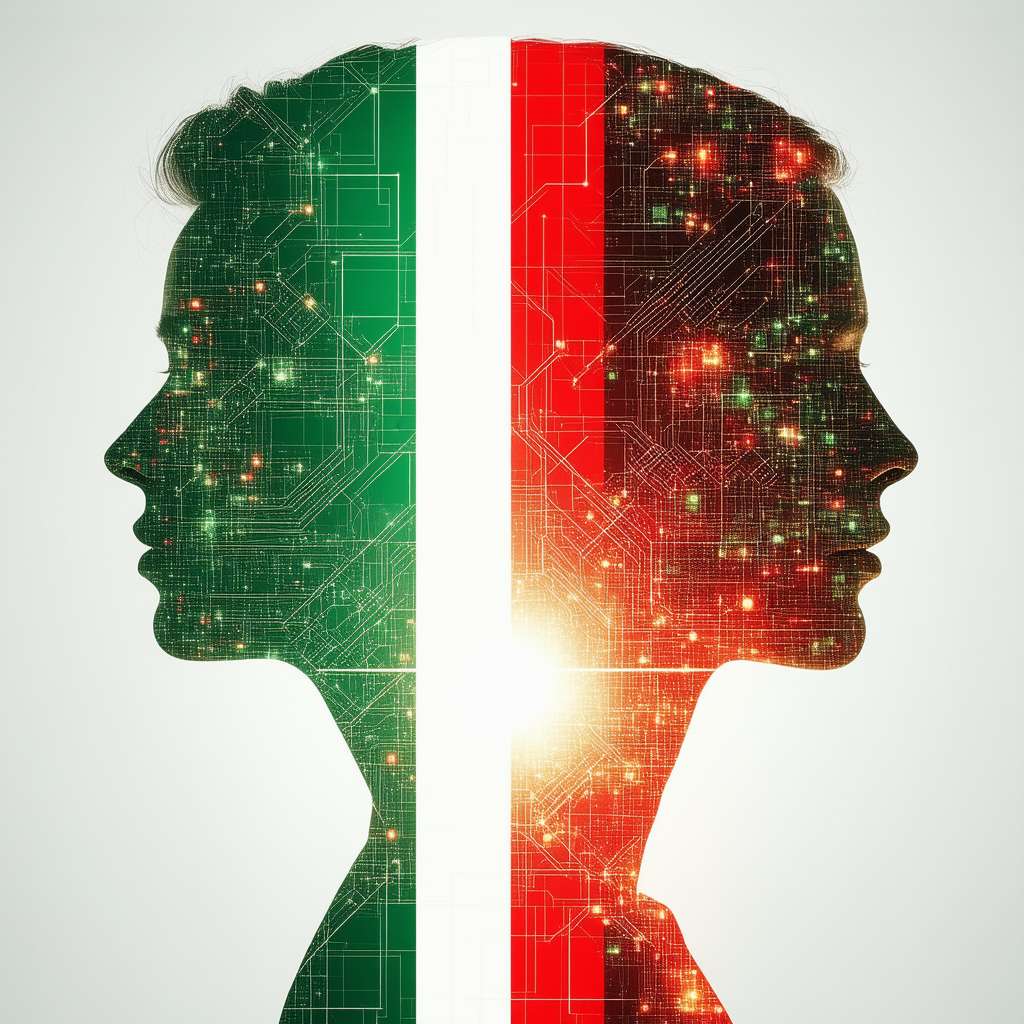

L’accelerazione della corsa all’AGI solleva importanti questioni etiche e geopolitiche. Chi controllerà la semantica dei dati? Chi deciderà cosa è un gatto, cosa è una minaccia, cosa è un volto felice? La capacità di modellare la realtà attraverso le etichette dei dati conferisce un potere enorme a chi controlla la “pipeline” dei dati. Meta, con il suo investimento in Scale AI, si posiziona come un attore chiave in questa arena, ma la sua influenza solleva preoccupazioni sulla possibilità di manipolazione e controllo della verità computazionale. Mentre Meta persegue la sua visione di un futuro guidato dall’IA, è fondamentale considerare le implicazioni etiche e garantire che l’AGI sia sviluppata in modo responsabile e trasparente.

Il Futuro dell’AGI: Una Riflessione Umana

L’articolo che abbiamo analizzato ci proietta in un futuro prossimo, un futuro in cui la competizione per l’intelligenza artificiale generale (AGI) si fa sempre più intensa. Ma cosa significa tutto questo per noi, esseri umani?

Per comprendere appieno la portata di questa corsa all’AGI, è utile richiamare un concetto fondamentale dell’intelligenza artificiale: il machine learning. Il machine learning è un paradigma di programmazione che permette alle macchine di apprendere dai dati, senza essere esplicitamente programmate per ogni singolo compito. In altre parole, le macchine imparano a riconoscere pattern, a fare previsioni e a prendere decisioni in base ai dati che vengono loro forniti.

Un concetto più avanzato, strettamente legato all’AGI, è il transfer learning. Il transfer learning è una tecnica che consente a un modello di intelligenza artificiale addestrato per un determinato compito di applicare le proprie conoscenze a un compito diverso, ma correlato. Ad esempio, un modello addestrato per riconoscere oggetti in immagini potrebbe essere adattato per riconoscere suoni o parole. Il transfer learning è fondamentale per l’AGI, poiché consente alle macchine di generalizzare le proprie conoscenze e di applicarle a una vasta gamma di problemi.

Ma al di là degli aspetti tecnici, è importante riflettere sulle implicazioni filosofiche e sociali di questa corsa all’AGI. Come esseri umani, siamo chiamati a interrogarci sul ruolo che vogliamo che l’intelligenza artificiale giochi nelle nostre vite. Vogliamo che l’AGI sia uno strumento al servizio dell’umanità, o vogliamo che diventi un’entità autonoma con i propri obiettivi e valori? La risposta a questa domanda determinerà il futuro dell’AGI e il futuro dell’umanità.