L’avvento dell’intelligenza artificiale (IA) ha aperto nuove frontiere in diversi settori, ma ha anche sollevato questioni etiche complesse, in particolare quando le macchine devono prendere decisioni in situazioni di vita o di morte. Il dilemma del “danno minore” emerge come una delle sfide più pressanti, richiedendo un’analisi approfondita di come gli algoritmi sono programmati per valutare le conseguenze delle loro azioni e come questi calcoli possono riflettere valori sociali controversi.

Il Problema del Carrello e le Auto a Guida Autonoma

Il dibattito sull’etica dell’IA è spesso incentrato sul cosiddetto “problema del carrello”, un esperimento mentale che presenta uno scenario in cui un carrello ferroviario fuori controllo sta per investire cinque persone. Un osservatore ha la possibilità di deviare il carrello su un altro binario, ma così facendo ucciderebbe una sola persona. La domanda è: è moralmente giustificabile sacrificare una vita per salvarne cinque? Questo dilemma, apparentemente astratto, diventa estremamente rilevante nel contesto delle auto a guida autonoma, che potrebbero trovarsi in situazioni in cui devono scegliere tra diverse opzioni, ognuna con conseguenze tragiche.

Immaginiamo un’auto a guida autonoma che, a causa di un guasto improvviso o di un ostacolo imprevisto, si trova di fronte a una scelta impossibile: investire un gruppo di pedoni o sterzare bruscamente, mettendo a rischio la vita del conducente. Come dovrebbe essere programmata l’auto per prendere questa decisione? Dovrebbe dare la priorità alla sicurezza del conducente, anche a costo di sacrificare la vita dei pedoni? O dovrebbe cercare di minimizzare il numero totale di vittime, anche se ciò significa mettere a rischio il conducente? Queste domande non hanno risposte facili e richiedono una riflessione approfondita sui valori che vogliamo incorporare nelle macchine che guidano le nostre vite.

Il Massachusetts Institute of Technology (MIT) ha lanciato nel 2016 il progetto “Moral Machine”, un sondaggio online che ha raccolto quasi 40 milioni di decisioni individuali da 233 paesi e territori. L’obiettivo era quello di capire come le persone di culture diverse affrontano i dilemmi morali e quali criteri considerano più importanti. I risultati hanno rivelato significative differenze culturali nelle preferenze etiche, suggerendo che non esiste un consenso universale su come le auto a guida autonoma dovrebbero essere programmate per prendere decisioni in situazioni di emergenza. Questo rende ancora più complesso il compito di sviluppare algoritmi che siano eticamente accettabili per tutti.

Sistemi di Supporto Decisionale Medico: Un’Altra Frontiera dell’Etica dell’Ia

Le sfide etiche legate all’IA non si limitano al settore automobilistico. I sistemi di supporto decisionale medico (clinical decision support systems, CDSS) stanno diventando sempre più diffusi negli ospedali e nelle cliniche di tutto il mondo. Questi sistemi utilizzano algoritmi di apprendimento automatico per analizzare grandi quantità di dati medici e fornire ai medici raccomandazioni su diagnosi, trattamenti e prognosi. Sebbene i CDSS abbiano il potenziale per migliorare significativamente la qualità dell’assistenza sanitaria, sollevano anche importanti questioni etiche.

Uno dei problemi principali è il rischio di bias algoritmico. Se i dati utilizzati per addestrare un CDSS riflettono pregiudizi esistenti nel sistema sanitario, l’algoritmo potrebbe perpetuare o addirittura amplificare queste disparità. Ad esempio, se un CDSS viene addestrato su dati che provengono principalmente da pazienti bianchi, potrebbe essere meno accurato nel diagnosticare malattie in pazienti di altre etnie. Questo potrebbe portare a un’assistenza sanitaria di qualità inferiore per i gruppi minoritari.

Un’altra sfida è la questione della trasparenza. Molti CDSS sono “scatole nere”, il che significa che è difficile capire come arrivano alle loro raccomandazioni. Questo può rendere difficile per i medici fidarsi del sistema e può anche sollevare problemi di responsabilità. Se un CDSS fornisce una raccomandazione errata che causa danni a un paziente, chi è responsabile? Il medico che ha seguito la raccomandazione? Il produttore del sistema? Il programmatore dell’algoritmo? Queste domande richiedono risposte chiare e precise.

Infine, c’è la questione dell’autonomia del paziente. I CDSS dovrebbero essere utilizzati solo come strumenti per supportare il processo decisionale del medico, non per sostituirlo. I pazienti dovrebbero avere il diritto di essere informati su come vengono utilizzati i CDSS nella loro assistenza sanitaria e dovrebbero avere la possibilità di rifiutare le raccomandazioni del sistema. È fondamentale garantire che l’IA sia utilizzata per migliorare l’assistenza sanitaria, non per minare l’autonomia e la dignità dei pazienti.

Responsabilità, Trasparenza e Accettabilità: I Pilastri di un’Etica dell’Ia Responsabile

Per affrontare le sfide etiche poste dall’IA, è necessario sviluppare un quadro di riferimento che si basi su tre pilastri fondamentali: responsabilità, trasparenza e accettabilità. La responsabilità implica che qualcuno deve essere ritenuto responsabile per le decisioni prese dall’IA, anche se queste decisioni sono complesse e difficili da comprendere. La trasparenza implica che le decisioni dell’IA devono essere comprensibili e giustificabili, in modo che le persone possano capire come sono state prese e perché. L’accettabilità implica che le decisioni dell’IA devono essere coerenti con i valori sociali e le norme etiche.

Garantire la responsabilità nell’era dell’IA è una sfida complessa, poiché le decisioni algoritmiche sono spesso il risultato di processi complessi e opachi. Tuttavia, è fondamentale stabilire meccanismi chiari per identificare e punire i comportamenti scorretti. Questo potrebbe includere la creazione di organismi di controllo indipendenti, l’introduzione di standard di certificazione per i sistemi di IA e lo sviluppo di leggi che definiscano chiaramente la responsabilità in caso di danni causati dall’IA. Le aziende devono essere incentivate a sviluppare sistemi di IA etici e responsabili, e devono essere punite se non lo fanno.

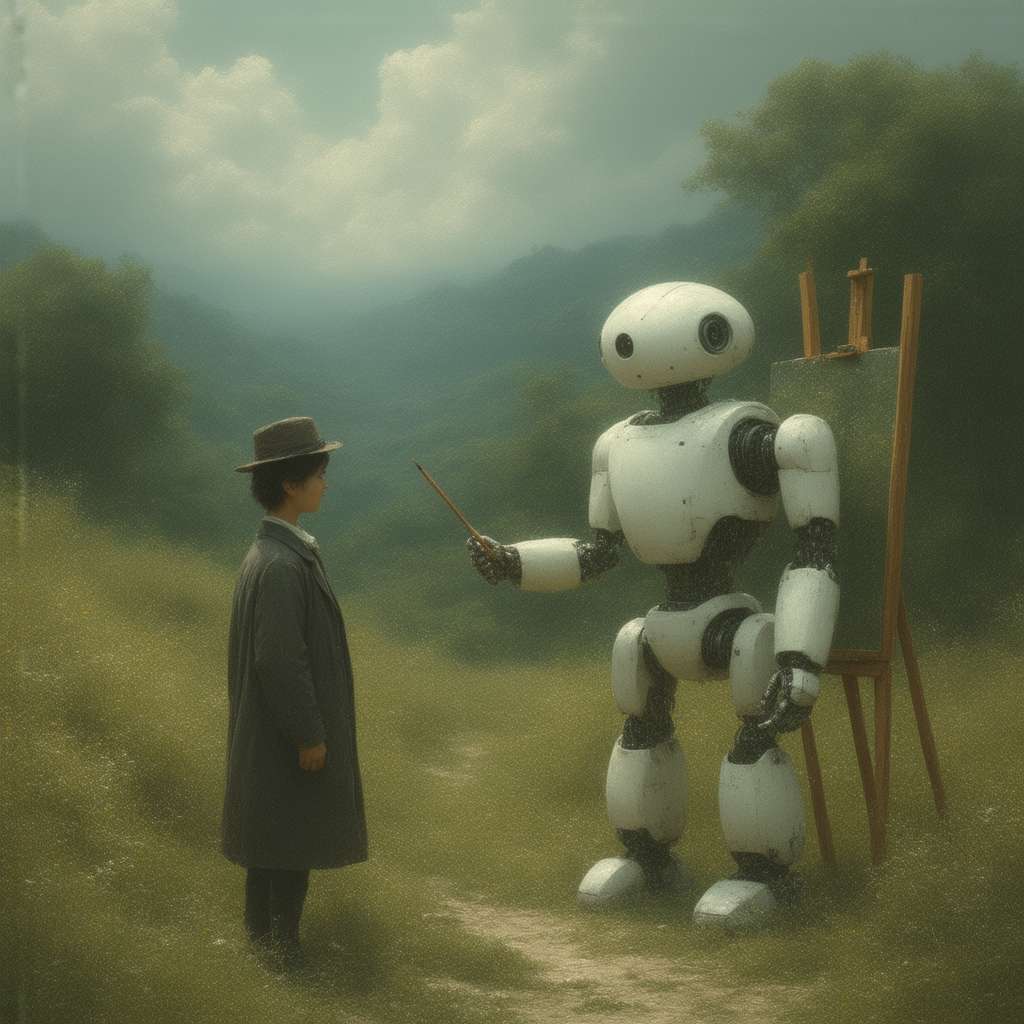

La trasparenza è un altro elemento cruciale per costruire la fiducia nell’IA. Le persone devono essere in grado di capire come funzionano i sistemi di IA e come prendono le loro decisioni. Questo richiede lo sviluppo di tecniche di “IA spiegabile” (explainable AI, XAI) che consentano di rendere più trasparenti i processi decisionali degli algoritmi. Inoltre, è importante promuovere la divulgazione di informazioni sui dati utilizzati per addestrare i sistemi di IA e sui criteri utilizzati per valutare le loro prestazioni. La trasparenza non solo aiuta a costruire la fiducia, ma consente anche di identificare e correggere i bias algoritmici.

Infine, l’accettabilità sociale è essenziale per garantire che l’IA sia utilizzata in modo responsabile e sostenibile. Le decisioni dell’IA devono essere coerenti con i valori e le norme etiche della società. Questo richiede un dialogo continuo tra esperti di IA, filosofi, giuristi e il pubblico in generale. È importante coinvolgere tutti gli attori interessati nel processo di definizione delle linee guida etiche per l’IA. Inoltre, è fondamentale educare il pubblico sui vantaggi e i rischi dell’IA, in modo che le persone possano prendere decisioni informate sul suo utilizzo. L’accettabilità sociale non è un concetto statico, ma evolve nel tempo con il progresso della tecnologia e i cambiamenti nei valori sociali.

Verso un Futuro con l’Ia: Considerazioni Finali

Navigare il complesso panorama etico dell’IA richiede un approccio olistico e multidisciplinare. Non si tratta solo di sviluppare algoritmi più sofisticati, ma anche di affrontare questioni fondamentali sulla natura della moralità, sulla responsabilità e sulla fiducia. La tecnologia IA offre un potenziale straordinario per migliorare la vita umana, ma solo se viene sviluppata e utilizzata in modo responsabile e consapevole. Il futuro dell’IA dipende dalla nostra capacità di affrontare le sfide etiche che essa pone.

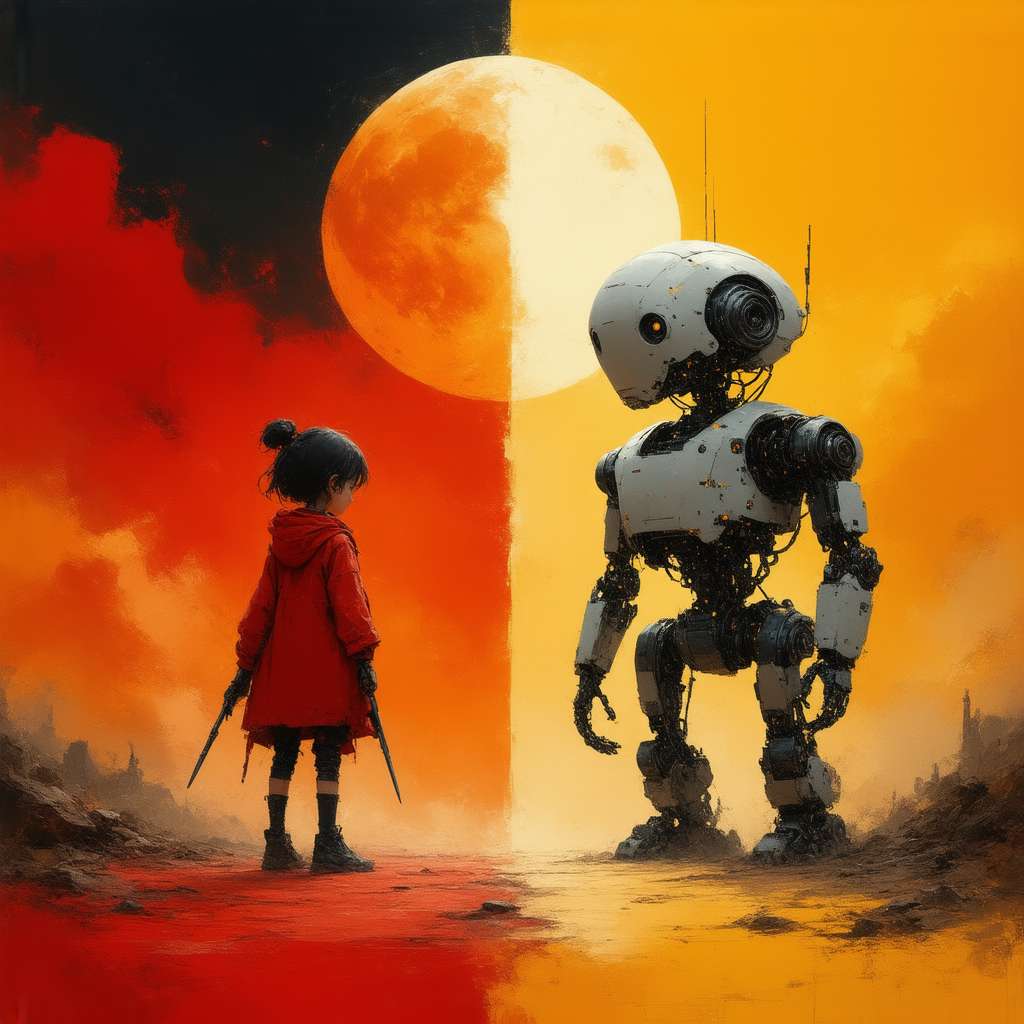

Una nozione base di intelligenza artificiale, fondamentale in questo contesto, è il concetto di machine learning*. Gli algoritmi di machine learning imparano dai dati, migliorando le loro prestazioni nel tempo. Un concetto più avanzato è il reinforcement learning*, dove l’IA impara attraverso tentativi ed errori, ricevendo “ricompense” per le azioni corrette e “punizioni” per quelle sbagliate. Immagina di addestrare un’auto a guida autonoma utilizzando il reinforcement learning: l’auto impara a guidare evitando incidenti e rispettando le regole della strada. Ma come definire le “ricompense” e le “punizioni” in situazioni di dilemma morale? Come possiamo insegnare a una macchina a distinguere tra il bene e il male? Riflettere su queste domande è essenziale per garantire che l’IA sia utilizzata in modo etico e responsabile.

Ed è qui che la riflessione personale diventa cruciale. Non possiamo delegare completamente alle macchine le decisioni che riguardano la vita e la morte. Dobbiamo interrogarci sui nostri valori, sulle nostre priorità e sulla nostra visione del mondo. Solo così potremo contribuire a plasmare un futuro in cui l’IA sia al servizio dell’umanità, non il contrario. Un futuro dove l’etica non è un semplice calcolo di probabilità, ma un impegno costante verso il bene comune.