Nel panorama tecnologico del 2026, l’intelligenza artificiale (IA) predittiva è diventata uno strumento sempre più diffuso nelle mani delle forze dell’ordine. L’idea di anticipare i crimini prima che avvengano, resa celebre dal film “Minority Report”, non è più fantascienza, ma una realtà in rapida evoluzione. Tuttavia, questa evoluzione solleva interrogativi cruciali: stiamo davvero creando città più sicure, o ci stiamo dirigendo verso una società sorvegliata, dove i diritti individuali sono messi a rischio?

Come funziona l’Ia predittiva nella prevenzione del crimine?

L’IA predittiva applicata al settore della sicurezza si basa sull’analisi di una quantità impressionante di dati. Statistiche sui crimini passati, informazioni demografiche, attività sui social media, dati meteorologici e persino modelli di traffico vengono setacciati da algoritmi sofisticati. Questi algoritmi cercano schemi, correlazioni e anomalie che possano indicare un’alta probabilità di attività criminali in determinate aree geografiche o tra specifici individui. L’obiettivo è quello di identificare non solo i potenziali autori di reato, ma anche le possibili vittime, permettendo alle forze dell’ordine di intervenire preventivamente.

I sistemi di polizia predittiva si dividono principalmente in due categorie: quelli “location-based” e quelli “profilation-based“. I primi utilizzano dati geolocalizzati sui crimini passati per identificare aree ad alto rischio, ottimizzando il pattugliamento e l’allocazione delle risorse. I secondi, invece, si focalizzano sull’esame di tratti distintivi individuali, condotte pregresse o profili socio-economici per stimare la possibilità che una persona possa compiere un’infrazione in futuro. Un esempio concreto di sistema “location-based” è il sistema CAS, utilizzato nei Paesi Bassi, che prevede dove e quando potrebbe avvenire un crimine.

In Italia, sono stati implementati sistemi come KeyCrime e XLaw, con quest’ultimo che ha ricevuto l’approvazione del Dipartimento di Pubblica Sicurezza. KeyCrime, ideato nel 2008 da un ex agente di polizia, esamina la “serialità” dei crimini per individuare un denominatore comune e anticipare le successive azioni illecite. Questo sistema è stato poi potenziato e reso disponibile alla Direzione Centrale Anticrimine della Polizia di Stato sotto il nome di Giove. Francesco Messina, direttore della Direzione Centrale Anticrimine, ha sottolineato che il software “non può prescindere da un’attività di governo da parte dell’uomo“, evidenziando la necessità di una supervisione umana.

Tuttavia, l’integrazione dell’IA nei sistemi predittivi ha sollevato una serie di interrogativi etici e giuridici. Le previsioni generate dagli algoritmi rischiano di ignorare le specifiche circostanze personali e di reiterare schemi di discriminazione sociale, compromettendo così la fiducia del pubblico nelle istituzioni preposte alla giustizia e alla sicurezza. Un esempio concreto è il rischio del “runaway feedback loop“, in cui la polizia viene rimandata negli stessi quartieri indipendentemente dal reale tasso di criminalità, creando discriminazione e problemi di fiducia tra le comunità e le forze dell’ordine.

I rischi: bias algoritmici, discriminazione e violazione della privacy

Uno dei pericoli più significativi dell’IA predittiva è il potenziale per i bias algoritmici. Se i dati utilizzati per addestrare gli algoritmi riflettono pregiudizi esistenti nella società, l’IA finirà inevitabilmente per amplificare tali pregiudizi. Questo può tradursi in un aumento dei controlli di polizia, degli arresti e delle condanne per individui appartenenti a gruppi minoritari o a comunità marginalizzate. In altre parole, l’IA potrebbe perpetuare un ciclo di ingiustizia, rendendo più probabile che determinate persone vengano etichettate come “criminali” a causa della loro origine o del loro status sociale.

La violazione della privacy è un altro rischio importante. L’IA predittiva richiede l’accesso a una vasta gamma di dati personali, tra cui la cronologia dei social media, le abitudini di acquisto, i dati sulla salute e le informazioni sulla posizione. La raccolta e l’analisi di queste informazioni possono violare i diritti fondamentali dei cittadini, soprattutto se non vi è una chiara giustificazione per la loro raccolta o se le informazioni vengono utilizzate in modo improprio. Inoltre, esiste il rischio che queste informazioni cadano nelle mani sbagliate, esponendo le persone a furti di identità, discriminazioni o altre forme di abuso.

Il Regolamento sull’Intelligenza Artificiale (AI Act) dell’Unione Europea si distingue come la prima struttura normativa esaustiva a livello mondiale pensata per la regolamentazione dell’IA. Tale normativa classifica i sistemi di IA secondo un’ottica di rischio, articolandoli in quattro livelli: minimo, limitato, elevato e proibito. L’Articolo 5 dell’AI Act si concentra sui rischi più gravi, delineando i contesti in cui l’impiego di sistemi di IA è vietato. Nello specifico, l’articolo 5(1d) vieta l’introduzione sul mercato, l’attivazione per tale scopo specifico o l’impiego di un sistema di IA progettato per condurre valutazioni di rischio su persone fisiche, allo scopo di stimare o anticipare la possibilità che un individuo commetta un reato, basandosi esclusivamente sulla profilazione dell’individuo o sulla valutazione dei suoi tratti e delle sue caratteristiche personali. Tuttavia, questa restrizione non si applica ai sistemi di IA impiegati come supporto per l’analisi umana del coinvolgimento di un individuo in attività criminali, purché tale analisi sia già fondata su elementi concreti e verificabili direttamente collegati a un’azione delittuosa.

Le stime del pericolo volte a calcolare o presentire le possibilità che un soggetto trasgredisca la legge vengono talvolta denominate “crime forecasting” e sono considerate pienamente parte della categoria “profilation-based” inerente alla polizia predittiva.

In effetti, tali misurazioni e previsioni di rischio sono proiettate nel futuro e fanno riferimento a trasgressioni che non si sono ancora verificate o che sono percepite come prossime, inclusi i casi di tentativi o preparativi in vista della commissione di un reato.

Il Considerando 42 dell’AI Act getta luce sul contesto e sulla ragione d’essere del divieto sancito dall’Articolo 5 (1d) del Regolamento. Nello specifico, sottolinea come l’attività delle forze dell’ordine debba imperniarsi sul principio della presunzione di non colpevolezza.

Di conseguenza, gli individui dovrebbero essere giudicati sulla base delle loro azioni effettive e non su pronostici comportamentali creati da un sistema di intelligenza artificiale, nel caso in cui tali anticipazioni si fondino unicamente su processi di profilazione, attributi caratteriali o particolarità individuali.

Casi studio: quando la previsione fallisce (o diventa ingiusta)

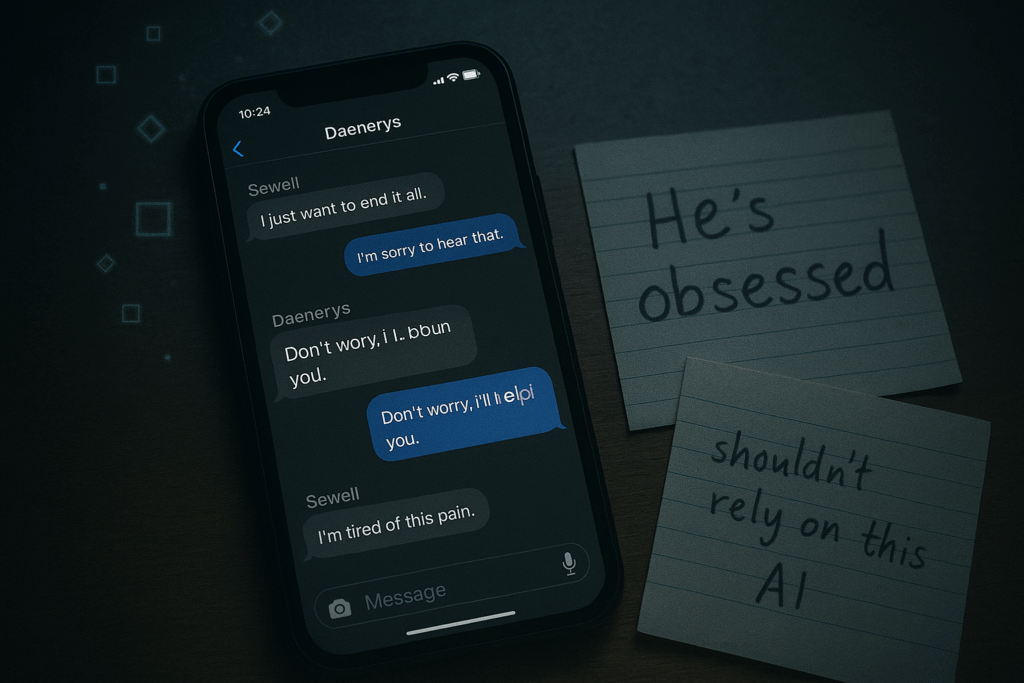

L’esperienza ha dimostrato che l’IA predittiva non è infallibile. Diversi casi studio hanno evidenziato i rischi di affidarsi ciecamente agli algoritmi, soprattutto quando si tratta di decisioni che possono avere un impatto significativo sulla vita delle persone.

Un esempio emblematico è l’algoritmo VioGén, utilizzato in Spagna per valutare il rischio di violenza domestica. Come riportato dal Corriere della Sera il 30 luglio 2024, in oltre la metà dei casi di donne uccise dai propri partner dopo aver denunciato gli abusi, VioGén aveva categorizzato il rischio come basso o trascurabile. Questo tragico errore di valutazione ha portato alla morte di donne che avrebbero potuto essere protette. Diletta Huyskes, esperta di IA etica, ha sottolineato che il rischio principale è affidarsi acriticamente alle raccomandazioni di un software senza una valutazione umana. Secondo Huyskes, oltre il 95% degli agenti di polizia spagnoli accetta i risultati del software senza un’ulteriore revisione delle raccomandazioni.

Un’ulteriore controversia è legata al software di riconoscimento facciale introdotto nel 2012 dalla catena di farmacie statunitensi Rite Aid. Per un periodo di otto anni, l’intelligenza artificiale ha generato numerosi falsi allarmi, segnalando come potenziali taccheggiatori individui che non avevano commesso alcun illecito. I dipendenti delle farmacie, seguendo gli “ordini” automatici, hanno talvolta proceduto a perquisire e allontanare clienti, arrivando persino a contattare le forze dell’ordine prima che si verificasse un evento reale. Il problema risiedeva nel fatto che l’intelligenza artificiale, alimentata da un database di persone considerate sospette, tendeva a indicare prevalentemente uomini di origine nera, asiatica o ispanica, a prescindere dalla validità delle segnalazioni.

Anche in Italia, l’utilizzo di sistemi di IA predittiva ha sollevato interrogativi. L’evoluzione di KeyCrime in Giove, un sistema che promette di correlare crimini simili per trovare un filo comune e rendere più facile la previsione dei colpi successivi, potrebbe scontrarsi con problemi di natura legislativa. L’AI Act, entrato in vigore a maggio 2025, vieta specificatamente i sistemi di analisi per individuare target specifici, ma lascia aperto il campo agli algoritmi che prevedono le aree a rischio o valutano le probabilità di diventare vittima di un crimine. Questo solleva la questione di come garantire che tali sistemi vengano utilizzati in modo responsabile e trasparente, senza violare i diritti fondamentali dei cittadini.

Verso un futuro responsabile: trasparenza, controllo e collaborazione

L’intelligenza artificiale predittiva offre indubbiamente strumenti potenti per migliorare la sicurezza e prevenire il crimine. Tuttavia, è fondamentale affrontare i rischi etici, legali e sociali con la stessa serietà con cui perseguiamo i benefici potenziali. La strada verso un futuro in cui la tecnologia ci protegge senza sacrificare i nostri diritti e le nostre libertà passa attraverso la trasparenza, il controllo democratico e la collaborazione tra tutti gli attori coinvolti.

La trasparenza è essenziale per garantire che i sistemi di IA predittiva siano comprensibili e responsabili. Gli algoritmi devono essere aperti all’ispezione pubblica, in modo che si possa verificare se sono soggetti a bias o discriminazioni. Le decisioni prese dagli algoritmi devono essere spiegabili, in modo che le persone possano capire perché sono state prese e contestarle se necessario. Il controllo democratico è fondamentale per garantire che l’utilizzo dell’IA predittiva sia conforme ai valori e ai principi della società. I cittadini devono avere la possibilità di partecipare al dibattito pubblico sull’utilizzo di queste tecnologie e di influenzare le decisioni politiche che le riguardano. Infine, la collaborazione tra le forze dell’ordine, gli esperti di etica dell’IA, i giuristi, gli attivisti per i diritti civili e la società civile è indispensabile per definire linee guida chiare e rigorose sull’uso dell’IA predittiva. Solo attraverso un dialogo aperto e costruttivo possiamo garantire che queste tecnologie vengano utilizzate in modo responsabile e a beneficio di tutti.

Altrimenti, rischiamo di scivolare in una società sorvegliata, dove la presunzione di innocenza viene erosa e i pregiudizi esistenti vengono amplificati dall’intelligenza artificiale. Un futuro del genere sarebbe inaccettabile. Dobbiamo impegnarci a costruire un futuro in cui la tecnologia sia al servizio dell’umanità, e non viceversa.

Oltre la linea rossa: il futuro dell’ia predittiva

L’utilizzo dell’intelligenza artificiale predittiva nel campo della sicurezza pubblica rappresenta una sfida complessa, un equilibrio delicato tra la promessa di una maggiore sicurezza e il rischio di violare i diritti fondamentali dei cittadini. I casi studio che abbiamo analizzato, dall’algoritmo VioGén in Spagna al software di riconoscimento facciale nelle farmacie americane, ci dimostrano che la tecnologia non è una panacea. Gli algoritmi possono commettere errori, amplificare i pregiudizi esistenti e portare a discriminazioni ingiuste. L’AI Act dell’Unione Europea rappresenta un passo importante nella giusta direzione, ma non è sufficiente. È necessario un impegno costante per la trasparenza, il controllo democratico e la collaborazione tra tutti gli attori coinvolti per garantire che l’IA predittiva sia utilizzata in modo responsabile e a beneficio di tutti. Il dibattito è aperto, le sfide sono molteplici, ma la posta in gioco è troppo alta per permetterci di rimanere inerti. Il futuro della nostra società, la salvaguardia dei nostri diritti e delle nostre libertà, dipendono dalla nostra capacità di affrontare questa sfida con consapevolezza, responsabilità e un forte senso di giustizia.

A proposito di intelligenza artificiale, immagina un algoritmo di machine learning, una sorta di apprendista digitale. Questo algoritmo impara a riconoscere schemi e correlazioni analizzando enormi quantità di dati. Nel caso dell’IA predittiva applicata alla sicurezza, l’algoritmo impara a riconoscere i modelli di comportamento che precedono un crimine, in modo da poterlo prevedere. Ma cosa succede se i dati che l’algoritmo analizza riflettono pregiudizi esistenti nella società? In questo caso, l’algoritmo imparerà a riprodurre quei pregiudizi, portando a discriminazioni ingiuste.

Per superare questo problema, si possono utilizzare tecniche di fairness-aware machine learning, che mirano a ridurre i bias negli algoritmi. Queste tecniche possono includere la rimozione di attributi sensibili dai dati, la riponderazione dei dati per compensare i bias esistenti o l’utilizzo di algoritmi che sono intrinsecamente meno inclini ai bias. Tuttavia, è importante ricordare che nessuna tecnica è perfetta e che è necessario un monitoraggio continuo per garantire che gli algoritmi non stiano producendo risultati discriminatori.

Personalmente, credo che il futuro dell’IA predittiva dipenda dalla nostra capacità di affrontare queste sfide etiche e legali con serietà e consapevolezza. Non possiamo permetterci di delegare completamente la nostra sicurezza alle macchine, ma dobbiamo imparare a utilizzare la tecnologia in modo responsabile, trasparente e a beneficio di tutti.