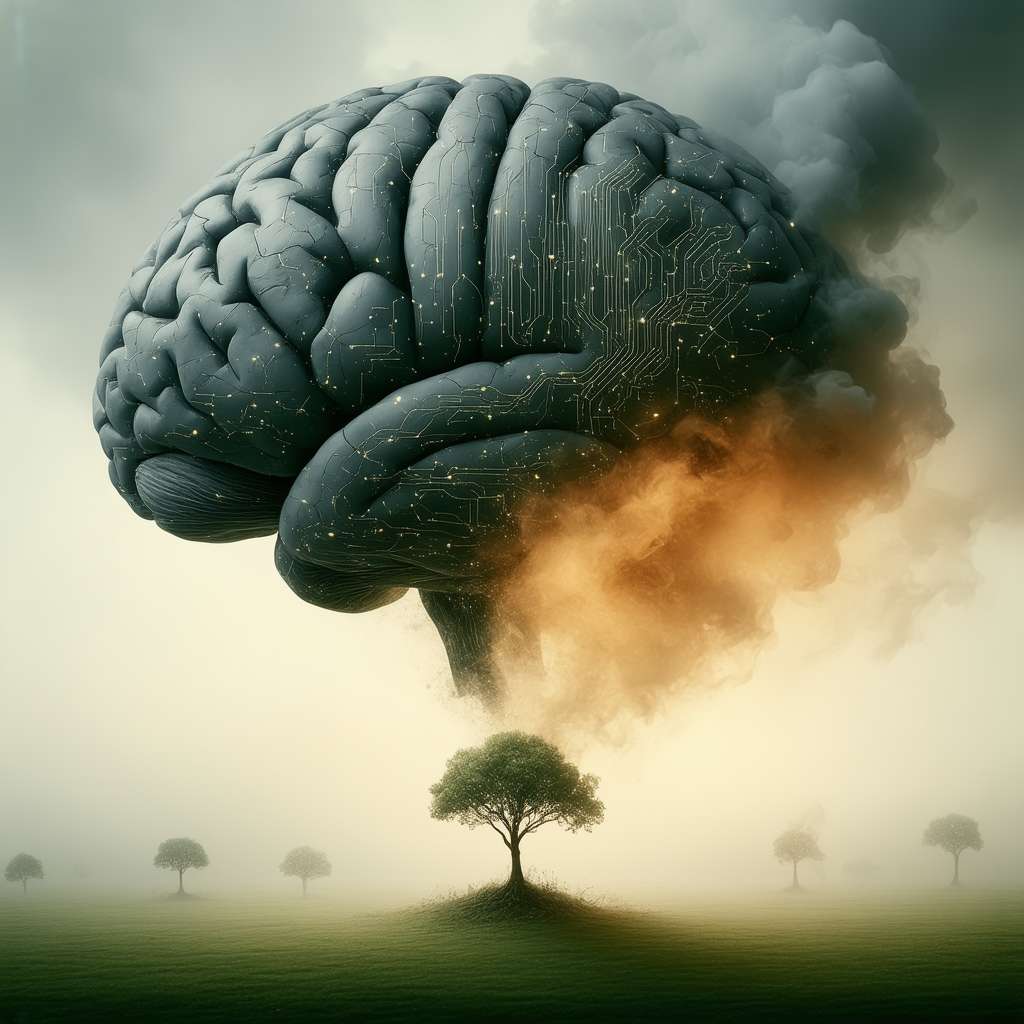

La rapida espansione dell’intelligenza artificiale, con le sue promesse di rivoluzione e progresso, getta un’ombra crescente sul nostro pianeta. Uno studio recente condotto dall’UNESCO ha messo in luce un trend preoccupante: il fabbisogno energetico dei sistemi di intelligenza artificiale raddoppia all’incirca ogni 100 giorni. Questa crescita esponenziale, alimentata dalla diffusione di piattaforme come ChatGPT e dalla pervasiva integrazione dell’IA nella vita di tutti i giorni, sta mettendo a dura prova le risorse mondiali, sollevando urgenti interrogativi riguardo alla sostenibilità ambientale.

Questa notizia riveste un’importanza cruciale poiché porta alla luce un aspetto spesso sottovalutato della rivoluzione dell’IA: le sue ripercussioni sull’ambiente. Mentre celebriamo i traguardi tecnologici, è essenziale considerare i costi nascosti in termini di dispendio energetico, consumo idrico e dipendenza da minerali critici. Non affrontare adeguatamente questa sfida potrebbe compromettere gli sforzi globali verso la sostenibilità e accelerare il cambiamento climatico.

Un’Analisi Dettagliata del Consumo Energetico

I dati emersi dallo studio dell’UNESCO sono a dir poco inquietanti. Per fare un esempio, una singola interazione con ChatGPT richiede in media 0,34 Wh di energia elettrica, un valore che può superare di 70 volte quello di una ricerca tradizionale su Google. Considerando che ChatGPT gestisce circa un miliardo di richieste al giorno, il suo consumo annuo si attesta sui 310 GWh, equivalenti al fabbisogno energetico di tre milioni di persone in Etiopia.

Questi numeri non solo evidenziano l’enorme quantità di energia necessaria per alimentare i sistemi di IA, ma anche la disparità nell’accesso alle risorse energetiche a livello globale. Mentre le nazioni sviluppate beneficiano dei vantaggi dell’IA, i paesi in via di sviluppo potrebbero subire le conseguenze del suo elevato consumo energetico.

Strategie per un Futuro Sostenibile

Di fronte a questa sfida, l’UNESCO ha delineato una serie di strategie pratiche per ridurre il consumo energetico dei sistemi di IA. Tra le soluzioni proposte, risalta l’importanza di formulare input più brevi e specifici, riducendo la lunghezza delle istruzioni e preferendo l’uso di modelli ottimizzati per compiti specifici rispetto a quelli di carattere generale. Gli esperti stimano che l’implementazione di tali accorgimenti potrebbe portare a una diminuzione del consumo energetico fino al 90%, rappresentando un passo cruciale verso una gestione più responsabile delle risorse.

Altre strategie includono:

Promuovere la ricerca e lo sviluppo di algoritmi e hardware a basso consumo energetico.

Favorire l’utilizzo di fonti di energia rinnovabile per alimentare i data center.

Adottare politiche di “green computing” nelle aziende.

Educare gli utenti sull’impatto ambientale dell’IA e incoraggiare un uso più consapevole.

Verso un’Intelligenza Artificiale Responsabile: Un Imperativo Etico

La crescente domanda di energia per l’IA solleva interrogativi profondi sul futuro della sostenibilità e sulla nostra responsabilità nei confronti del pianeta. È indispensabile che sviluppatori, aziende, governi e utenti lavorino insieme per creare un ecosistema di IA più efficiente, equo e rispettoso dell’ambiente.

L’adozione di standard etici e linee guida chiare è fondamentale per garantire che l’IA sia sviluppata e utilizzata in modo responsabile. Ciò include la trasparenza nel consumo energetico, la valutazione dell’impatto ambientale e la promozione di pratiche di utilizzo sostenibili.

L’intelligenza artificiale ha il potenziale per trasformare il mondo in meglio, ma solo se affrontiamo le sfide ambientali che essa comporta con urgenza e determinazione.

*

Amici lettori, riflettiamo un attimo. L’articolo che abbiamo esplorato ci mette di fronte a una realtà ineludibile: l’intelligenza artificiale, per quanto affascinante e potente, ha un costo energetico significativo. Per comprendere meglio questa dinamica, possiamo introdurre un concetto fondamentale dell’IA: l’apprendimento automatico.

L’apprendimento automatico è il processo attraverso il quale un sistema di IA impara dai dati, migliorando le proprie prestazioni nel tempo. Questo processo richiede un’enorme quantità di calcoli, che a loro volta consumano energia. Più complesso è il modello di IA e più dati deve elaborare, maggiore sarà il suo fabbisogno energetico.

Ma non fermiamoci qui. Un concetto più avanzato, che si lega strettamente al tema dell’articolo, è quello dell’AI frugale. L’AI frugale si concentra sullo sviluppo di modelli di IA che siano efficienti dal punto di vista energetico e che richiedano meno risorse computazionali. Questo approccio mira a democratizzare l’accesso all’IA, rendendola disponibile anche in contesti con risorse limitate, e a ridurre il suo impatto ambientale.

Ora, vi invito a una riflessione personale: come possiamo, nel nostro piccolo, contribuire a un futuro dell’IA più sostenibile? Possiamo iniziare con semplici gesti, come formulare richieste più concise ai chatbot o scegliere applicazioni di IA che siano state progettate con un’attenzione particolare all’efficienza energetica. Ogni piccolo passo conta, e insieme possiamo fare la differenza.