Nel contesto odierno, caratterizzato da una pervasiva integrazione dell’intelligenza artificiale in ogni aspetto della nostra società, emerge un interrogativo cruciale: l’alfabetizzazione in materia di IA rappresenta un’autentica opportunità di emancipazione civica oppure si configura come un mero strumento di controllo, volto a promuovere un’adesione acritica alle tecnologie emergenti? L’analisi critica di iniziative quali i corsi gratuiti sull’IA promossi nelle scuole e nelle biblioteche, prendendo ad esempio l’esperienza di Bibbiena, si rivela essenziale per comprendere la reale portata di tali programmi.

Chi definisce il curriculum?

La proliferazione di corsi gratuiti sull’intelligenza artificiale, promossi in diverse sedi istituzionali, solleva interrogativi fondamentali in merito alla definizione dei programmi didattici. Chi sono i soggetti responsabili della determinazione dei contenuti? Quali sono le competenze che vengono effettivamente trasmesse ai partecipanti? L’analisi di queste dinamiche si rivela imprescindibile per valutare se tali iniziative promuovano un’autentica alfabetizzazione, in grado di rendere i cittadini più consapevoli e capaci di utilizzare l’IA in modo critico, oppure se si tratti di operazioni di marketing finalizzate a favorire un’adozione indiscriminata delle tecnologie. A Bibbiena, ad esempio, l’iniziativa di offrire corsi gratuiti sull’IA per la cittadinanza attiva ha suscitato un dibattito in merito all’effettiva trasparenza dei contenuti e alla loro aderenza ai principi di un’educazione civica responsabile. È necessario accertare se tali programmi siano stati progettati con l’obiettivo di fornire una comprensione equilibrata dell’IA, evidenziandone sia i vantaggi che i potenziali rischi, oppure se siano stati concepiti per promuovere una visione eccessivamente ottimistica, funzionale agli interessi di specifici settori economici o gruppi di pressione. Le “Linee Guida per l’insegnamento dell’educazione civica”, adottate con il decreto del Ministero dell’Istruzione e del Merito numero 183 del 7 settembre 2024, considerano l’IA uno strumento utilissimo per personalizzare la didattica e gli apprendimenti. Tuttavia, tale approccio solleva interrogativi in merito alla necessità di promuovere un pensiero critico nei confronti dell’IA, al fine di evitare una passiva accettazione delle sue applicazioni. La fiducia cieca nell’IA, infatti, potrebbe comportare una diminuzione della capacità di analisi autonoma e un’erosione del pensiero critico, come evidenziato da recenti studi condotti da Microsoft e dalla Carnegie Mellon University. In tale contesto, diviene fondamentale che le istituzioni scolastiche e formative si impegnino a garantire la trasparenza dei contenuti dei corsi sull’IA, promuovendo un approccio multidisciplinare che integri competenze tecniche, etiche e sociali. Solo in questo modo sarà possibile trasformare l’alfabetizzazione sull’IA in un autentico strumento di potere per i cittadini, consentendo loro di partecipare attivamente alla costruzione di una società digitale più equa e responsabile.

Competenze insegnate: marketing o consapevolezza?

La valutazione delle competenze effettivamente insegnate nei corsi di alfabetizzazione all’IA rappresenta un aspetto cruciale per comprendere la reale efficacia di tali iniziative. È fondamentale accertare se i programmi didattici siano focalizzati sulla trasmissione di competenze tecniche di base, utili per l’utilizzo pratico dell’IA, oppure se promuovano una comprensione più ampia e critica delle implicazioni etiche, sociali e politiche di tali tecnologie. Un approccio autenticamente orientato all’alfabetizzazione dovrebbe fornire ai partecipanti gli strumenti necessari per valutare in modo autonomo le applicazioni dell’IA, identificandone i potenziali rischi e benefici, e per partecipare attivamente al dibattito pubblico in merito alle sue implicazioni. In tal senso, il Regolamento UE 2024/1698 (AI Act) definisce l’alfabetizzazione in materia di IA come “le competenze, le conoscenze e la comprensione che consentono ai fornitori, agli utenti e alle persone interessate di procedere a una diffusione informata dei sistemi di IA, nonché di acquisire consapevolezza in merito alle opportunità e ai rischi dell’IA e ai possibili danni che essa può causare”. Questa definizione sottolinea l’importanza di un approccio equilibrato, che non si limiti a promuovere i vantaggi dell’IA, ma che affronti anche le sue potenziali criticità. L’analisi dei contenuti dei corsi promossi a Bibbiena, ad esempio, dovrebbe verificare se tali programmi affrontino tematiche quali la trasparenza degli algoritmi, la protezione dei dati personali, la responsabilità degli sviluppatori di IA e le implicazioni occupazionali dell’automazione. Inoltre, è necessario accertare se i corsi promuovano lo sviluppo di competenze trasversali quali il pensiero critico, la capacità di problem solving e la comunicazione efficace, al fine di consentire ai partecipanti di interagire in modo consapevole e responsabile con le tecnologie IA. In caso contrario, l’alfabetizzazione sull’IA rischia di trasformarsi in una mera operazione di marketing, finalizzata a promuovere l’adozione acritica di tali tecnologie, senza fornire ai cittadini gli strumenti necessari per valutarne autonomamente le implicazioni. Come ha sottolineato Laura Biancato, dirigente scolastico dell’ITET Luigi Einaudi durante la Maratona FORUM PA 2024, “Non possiamo limitarci a insegnare come usare le tecnologie: dobbiamo educare i ragazzi a riflettere criticamente sulle informazioni che trovano online”. È fondamentale, quindi, che la scuola prepari gli studenti a diventare cittadini digitali consapevoli, in grado di analizzare le fonti, valutare l’affidabilità delle informazioni e distinguere tra vero e falso in contesti sempre più complessi.

Alfabetizzazione ai e pensiero critico

Il nesso inscindibile tra alfabetizzazione all’IA e sviluppo del pensiero critico rappresenta un elemento centrale per garantire che tali iniziative promuovano un’autentica cittadinanza attiva nell’era digitale. L’IA, infatti, non è una tecnologia neutrale, bensì un insieme di algoritmi e modelli matematici che riflettono le scelte e i pregiudizi dei suoi sviluppatori. Pertanto, è fondamentale che i cittadini siano in grado di comprendere il funzionamento di tali sistemi, identificandone i potenziali bias e valutandone criticamente le applicazioni. Come evidenzia TuttoScuola.com, in un’epoca segnata dalla sovrabbondanza informativa, “la capacità di distinguere ciò che è autentico da ciò che è distorto, ciò che è documentato da ciò che è basato su interessi ideologici o commerciali, diventa sempre più difficile da esercitare”. In tale contesto, “la scuola assume un ruolo strategico e imprescindibile. Solo attraverso percorsi formativi mirati e consapevoli, in grado di potenziare il pensiero critico, si può costruire una cittadinanza attiva e responsabile”. L’alfabetizzazione all’IA, quindi, non può essere ridotta a un semplice addestramento tecnico, bensì deve promuovere lo sviluppo di competenze trasversali quali la capacità di analisi, la valutazione delle fonti, il ragionamento logico e la comunicazione efficace. È necessario che i partecipanti ai corsi siano in grado di interrogarsi sulle implicazioni etiche, sociali e politiche dell’IA, valutando criticamente le sue applicazioni in diversi contesti, dal lavoro alla sanità, dalla giustizia all’istruzione. Inoltre, è fondamentale che i corsi promuovano la consapevolezza dei rischi connessi all’utilizzo dell’IA, quali la manipolazione dell’opinione pubblica, la discriminazione algoritmica e la violazione della privacy. In tal senso, l’esperienza di Bibbiena, come quella di altre realtà italiane, dovrebbe essere valutata alla luce della sua capacità di promuovere un approccio critico all’IA, fornendo ai partecipanti gli strumenti necessari per valutare in modo autonomo le sue implicazioni e per partecipare attivamente al dibattito pubblico in merito al suo sviluppo. Solo in questo modo, l’alfabetizzazione all’IA potrà trasformarsi in un autentico strumento di potere per i cittadini, consentendo loro di esercitare un controllo democratico sulle tecnologie che plasmano il nostro futuro. L’eccessiva dipendenza dagli strumenti di intelligenza artificiale, inoltre, potrebbe ridurre la nostra capacità di pensare in modo critico e autonomo. Uno studio recente condotto da Microsoft e dalla Carnegie Mellon University, citato in un articolo su LinkedIn, mette in luce come, nel momento in cui un utente percepisce l’IA come più affidabile o efficiente di sé stesso, sia più propenso a delegare interamente il processo decisionale, riducendo la necessità di analizzare autonomamente i problemi.

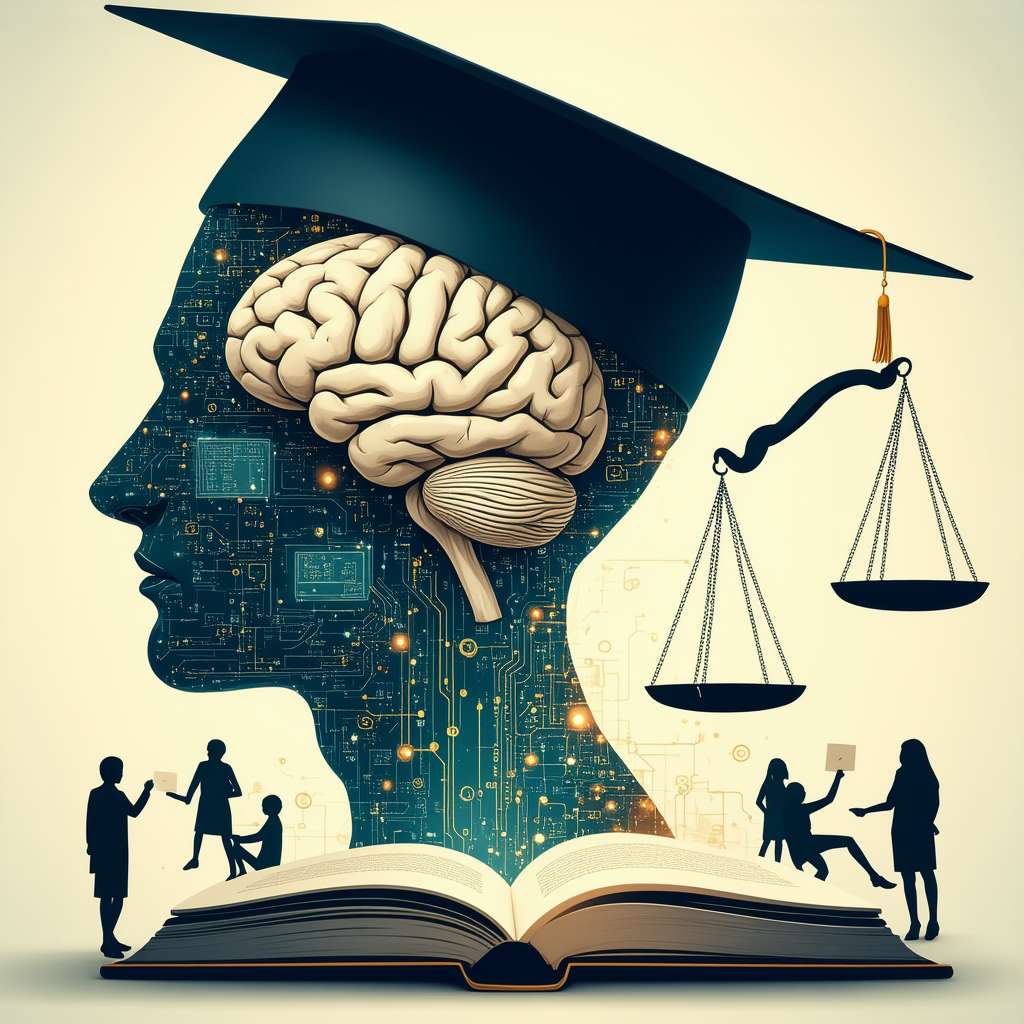

TOREPLACE = Create an iconographic image depicting the main entities of the article: a stylized human brain (symbolizing critical thinking) intertwined with glowing circuits representing AI, a book (symbolizing education), and a ballot box (symbolizing active citizenship). The brain should be detailed in a naturalistic style, while the AI circuits are more abstract and luminous. The book should appear open and inviting, and the ballot box should be clearly recognizable. The overall style should be inspired by naturalist and impressionist art, using a warm, desaturated color palette. The image should evoke a sense of wonder and intellectual curiosity. No text should be present.”

Verso un futuro digitale umanistico

L’obiettivo ultimo dell’alfabetizzazione all’IA non è semplicemente quello di fornire ai cittadini competenze tecniche, bensì di promuovere una visione umanistica del futuro digitale. Ciò implica la necessità di integrare la tecnologia con i valori fondamentali della nostra società, quali la dignità umana, la giustizia sociale, la libertà di espressione e la tutela dell’ambiente. In tal senso, l’alfabetizzazione all’IA deve promuovere la consapevolezza dei rischi connessi all’utilizzo di tali tecnologie, quali la disoccupazione tecnologica, la polarizzazione sociale e la sorveglianza di massa. È fondamentale che i cittadini siano in grado di comprendere come l’IA possa essere utilizzata per amplificare le disuguaglianze esistenti e per limitare le libertà individuali. Pertanto, è necessario che i corsi di alfabetizzazione all’IA promuovano lo sviluppo di competenze etiche e sociali, fornendo ai partecipanti gli strumenti necessari per valutare criticamente le implicazioni delle tecnologie IA e per partecipare attivamente alla definizione di un futuro digitale più equo e sostenibile. Ciò implica la necessità di promuovere un approccio multidisciplinare che integri competenze tecniche, umanistiche e sociali, al fine di formare cittadini in grado di comprendere la complessità del mondo digitale e di contribuire attivamente alla sua evoluzione. L’esperienza di Bibbiena, come quella di altre realtà italiane, dovrebbe essere valutata alla luce della sua capacità di promuovere una visione umanistica del futuro digitale, fornendo ai partecipanti gli strumenti necessari per esercitare un controllo democratico sulle tecnologie che plasmano il nostro futuro. Solo in questo modo, l’alfabetizzazione all’IA potrà trasformarsi in un autentico motore di progresso sociale, consentendo ai cittadini di partecipare attivamente alla costruzione di una società digitale più equa, inclusiva e sostenibile. In questa prospettiva, l’educazione civica assume un ruolo centrale, fornendo ai cittadini gli strumenti concettuali e metodologici necessari per comprendere le implicazioni etiche, sociali e politiche delle tecnologie IA e per partecipare attivamente al dibattito pubblico in merito al loro sviluppo.

Amici, parlando di intelligenza artificiale e di come essa influenzi la nostra capacità di pensiero critico, è utile sapere che alla base di molti sistemi di IA c’è il concetto di “machine learning“. In parole semplici, il machine learning è un metodo che permette alle macchine di imparare dai dati senza essere esplicitamente programmate. Ad esempio, un algoritmo di machine learning può analizzare migliaia di articoli di notizie per imparare a distinguere tra quelli veri e quelli falsi. E se volessimo qualcosa di più avanzato? Immaginate un sistema di IA che non solo impara dai dati, ma è anche in grado di spiegare il perché delle sue decisioni. Questo è ciò che si intende per “explainable AI” (XAI). Invece di una semplice risposta, otterremmo una spiegazione dettagliata, aiutandoci a capire meglio il processo decisionale della macchina e a fidarci di più (o meno) dei suoi risultati.

Ma, pensandoci bene, non è forse questa la stessa cosa che cerchiamo di fare noi con il pensiero critico? Interrogarci, analizzare, capire il perché delle cose… Forse, alla fine, l’IA può essere uno strumento per affinare le nostre capacità, a patto di non dimenticare mai di usare la nostra testa.

html

L’Alfabetizzazione AI per la Cittadinanza Attiva: Un’Utopia o uno Strumento di Potere?

Nel contesto odierno, caratterizzato da una pervasiva integrazione dell’intelligenza artificiale in ogni aspetto della nostra società, emerge un interrogativo cruciale: l’alfabetizzazione in materia di IA rappresenta un’autentica opportunità di emancipazione civica oppure si configura come un mero strumento di controllo, volto a promuovere un’adesione acritica alle tecnologie emergenti? L’analisi critica di iniziative quali i corsi gratuiti sull’IA promossi nelle scuole e nelle biblioteche, prendendo ad esempio l’esperienza di Bibbiena, si rivela essenziale per comprendere la reale portata di tali programmi.

Chi definisce il curriculum?

La proliferazione di corsi gratuiti sull’intelligenza artificiale, promossi in diverse sedi istituzionali, solleva interrogativi fondamentali in merito alla definizione dei programmi didattici. Chi sono i soggetti responsabili della determinazione dei contenuti? Quali sono le competenze che vengono effettivamente trasmesse ai partecipanti? L’analisi di queste dinamiche si rivela imprescindibile per valutare se tali iniziative promuovano un’autentica alfabetizzazione, in grado di rendere i cittadini più consapevoli e capaci di utilizzare l’IA in modo critico, oppure se si tratti di operazioni di marketing finalizzate a favorire un’adozione indiscriminata delle tecnologie. A Bibbiena, ad esempio, l’iniziativa di offrire corsi gratuiti sull’IA per la cittadinanza attiva ha suscitato un dibattito in merito all’effettiva trasparenza dei contenuti e alla loro aderenza ai principi di un’educazione civica responsabile. È necessario accertare se tali programmi siano stati progettati con l’obiettivo di fornire una comprensione equilibrata dell’IA, evidenziandone sia i vantaggi che i potenziali rischi, oppure se siano stati concepiti per promuovere una visione eccessivamente ottimistica, funzionale agli interessi di specifici settori economici o gruppi di pressione. Le “Linee Guida per l’insegnamento dell’educazione civica”, adottate con il decreto del Ministero dell’Istruzione e del Merito numero 183 del 7 settembre 2024, considerano l’IA uno strumento utilissimo per personalizzare la didattica e gli apprendimenti. Tuttavia, tale approccio solleva interrogativi in merito alla necessità di promuovere un pensiero critico nei confronti dell’IA, al fine di evitare una passiva accettazione delle sue applicazioni. La fiducia cieca nell’IA, infatti, potrebbe comportare una diminuzione della capacità di analisi autonoma e un’erosione del pensiero critico, come evidenziato da recenti studi condotti da Microsoft e dalla Carnegie Mellon University. In tale contesto, diviene fondamentale che le istituzioni scolastiche e formative si impegnino a garantire la trasparenza dei contenuti dei corsi sull’IA, promuovendo un approccio multidisciplinare che integri competenze tecniche, etiche e sociali. Solo in questo modo sarà possibile trasformare l’alfabetizzazione sull’IA in un autentico strumento di potere per i cittadini, consentendo loro di partecipare attivamente alla costruzione di una società digitale più equa e responsabile.

Competenze insegnate: marketing o consapevolezza?

La valutazione delle competenze effettivamente insegnate nei corsi di alfabetizzazione all’IA rappresenta un aspetto cruciale per comprendere la reale efficacia di tali iniziative. È fondamentale accertare se i programmi didattici siano focalizzati sulla trasmissione di competenze tecniche di base, utili per l’utilizzo pratico dell’IA, oppure se promuovano una comprensione più ampia e critica delle implicazioni etiche, sociali e politiche di tali tecnologie. Un approccio autenticamente orientato all’alfabetizzazione dovrebbe fornire ai partecipanti gli strumenti necessari per valutare in modo autonomo le applicazioni dell’IA, identificandone i potenziali rischi e benefici, e per partecipare attivamente al dibattito pubblico in merito alle sue implicazioni. In tal senso, il Regolamento UE 2024/1698 (AI Act) definisce l’alfabetizzazione in materia di IA come “le competenze, le conoscenze e la comprensione che consentono ai fornitori, agli utenti e alle persone interessate di procedere a una diffusione informata dei sistemi di IA, nonché di acquisire consapevolezza in merito alle opportunità e ai rischi dell’IA e ai possibili danni che essa può causare”. Questa definizione sottolinea l’importanza di un approccio equilibrato, che non si limiti a promuovere i vantaggi dell’IA, ma che affronti anche le sue potenziali criticità. L’analisi dei contenuti dei corsi promossi a Bibbiena, ad esempio, dovrebbe verificare se tali programmi affrontino tematiche quali la trasparenza degli algoritmi, la protezione dei dati personali, la responsabilità degli sviluppatori di IA e le implicazioni occupazionali dell’automazione. Inoltre, è necessario accertare se i corsi promuovano lo sviluppo di competenze trasversali quali il pensiero critico, la capacità di problem solving e la comunicazione efficace, al fine di consentire ai partecipanti di interagire in modo consapevole e responsabile con le tecnologie IA. In caso contrario, l’alfabetizzazione sull’IA rischia di trasformarsi in una mera operazione di marketing, finalizzata a promuovere l’adozione acritica di tali tecnologie, senza fornire ai cittadini gli strumenti necessari per valutarne autonomamente le implicazioni. Come ha sottolineato Laura Biancato, dirigente scolastico dell’ITET Luigi Einaudi durante la Maratona FORUM PA 2024, “Non possiamo limitarci a insegnare come usare le tecnologie: dobbiamo educare i ragazzi a riflettere criticamente sulle informazioni che trovano online”. *Risulta pertanto imprescindibile che l’istituzione scolastica prepari i discenti a divenire attori digitali consapevoli, capaci di vagliare le fonti, stimare l’attendibilità delle notizie e discernere il vero dal mendace in contesti sempre più complessi.

Alfabetizzazione ai e pensiero critico

Il nesso inscindibile tra alfabetizzazione all’IA e sviluppo del pensiero critico rappresenta un elemento centrale per garantire che tali iniziative promuovano un’autentica cittadinanza attiva nell’era digitale. L’IA, infatti, non è una tecnologia neutrale, bensì un insieme di algoritmi e modelli matematici che riflettono le scelte e i pregiudizi dei suoi sviluppatori. Pertanto, è fondamentale che i cittadini siano in grado di comprendere il funzionamento di tali sistemi, identificandone i potenziali bias e valutandone criticamente le applicazioni. Come evidenzia TuttoScuola.com, “come si manifesta in un periodo contraddistinto da un’abbondanza smisurata di notizie, l’abilità di riconoscere ciò che è genuino da ciò che è alterato, ciò che è supportato da prove concrete da ciò che è radicato in interessi ideologici o commerciali, si fa sempre più ardua da mettere in pratica”. In tale contesto, “l’istituzione scolastica riveste una funzione strategica e irrinunciabile”. “Solo attraverso itinerari formativi specifici e oculati, atti a intensificare l’abilità di ragionamento critico, è fattibile edificare una cittadinanza operativa e responsabile”.* L’alfabetizzazione all’IA, quindi, non può essere ridotta a un semplice addestramento tecnico, bensì deve promuovere lo sviluppo di competenze trasversali quali la capacità di analisi, la valutazione delle fonti, il ragionamento logico e la comunicazione efficace. È necessario che i partecipanti ai corsi siano in grado di interrogarsi sulle implicazioni etiche, sociali e politiche dell’IA, valutando criticamente le sue applicazioni in diversi contesti, dal lavoro alla sanità, dalla giustizia all’istruzione. Inoltre, è fondamentale che i corsi promuovano la consapevolezza dei rischi connessi all’utilizzo dell’IA, quali la manipolazione dell’opinione pubblica, la discriminazione algoritmica e la violazione della privacy. In tal senso, l’esperienza di Bibbiena, come quella di altre realtà italiane, dovrebbe essere valutata alla luce della sua capacità di promuovere un approccio critico all’IA, fornendo ai partecipanti gli strumenti necessari per valutare in modo autonomo le sue implicazioni e per partecipare attivamente al dibattito pubblico in merito al suo sviluppo. Solo in questo modo, l’alfabetizzazione all’IA potrà trasformarsi in un autentico strumento di potere per i cittadini, consentendo loro di esercitare un controllo democratico sulle tecnologie che plasmano il nostro futuro. L’eccessiva dipendenza dagli strumenti di intelligenza artificiale, inoltre, potrebbe ridurre la nostra capacità di pensare in modo critico e autonomo. Uno studio recente condotto da Microsoft e dalla Carnegie Mellon University, citato in un articolo su LinkedIn, mette in luce come, nel momento in cui un utente percepisce l’IA come più affidabile o efficiente di sé stesso, sia più propenso a delegare interamente il processo decisionale, riducendo la necessità di analizzare autonomamente i problemi.

TOREPLACE = Create an iconographic image depicting the main entities of the article: a stylized human brain (symbolizing critical thinking) intertwined with glowing circuits representing AI, a book (symbolizing education), and a ballot box (symbolizing active citizenship). The brain should be detailed in a naturalistic style, while the AI circuits are more abstract and luminous. The book should appear open and inviting, and the ballot box should be clearly recognizable. The overall style should be inspired by naturalist and impressionist art, using a warm, desaturated color palette. The image should evoke a sense of wonder and intellectual curiosity. No text should be present.”

Verso un futuro digitale umanistico

L’obiettivo ultimo dell’alfabetizzazione all’IA non è semplicemente quello di fornire ai cittadini competenze tecniche, bensì di promuovere una visione umanistica del futuro digitale. Ciò implica la necessità di integrare la tecnologia con i valori fondamentali della nostra società, quali la dignità umana, la giustizia sociale, la libertà di espressione e la tutela dell’ambiente. In tal senso, l’alfabetizzazione all’IA deve promuovere la consapevolezza dei rischi connessi all’utilizzo di tali tecnologie, quali la disoccupazione tecnologica, la polarizzazione sociale e la sorveglianza di massa. È fondamentale che i cittadini siano in grado di comprendere come l’IA possa essere utilizzata per amplificare le disuguaglianze esistenti e per limitare le libertà individuali. Pertanto, è necessario che i corsi di alfabetizzazione all’IA promuovano lo sviluppo di competenze etiche e sociali, fornendo ai partecipanti gli strumenti necessari per valutare criticamente le implicazioni delle tecnologie IA e per partecipare attivamente alla definizione di un futuro digitale più equo e sostenibile. Ciò implica la necessità di promuovere un approccio multidisciplinare che integri competenze tecniche, umanistiche e sociali, al fine di formare cittadini in grado di comprendere la complessità del mondo digitale e di contribuire attivamente alla sua evoluzione. L’esperienza di Bibbiena, come quella di altre realtà italiane, dovrebbe essere valutata alla luce della sua capacità di promuovere una visione umanistica del futuro digitale, fornendo ai partecipanti gli strumenti necessari per esercitare un controllo democratico sulle tecnologie che plasmano il nostro futuro. Solo in questo modo, l’alfabetizzazione all’IA potrà trasformarsi in un autentico motore di progresso sociale, consentendo ai cittadini di partecipare attivamente alla costruzione di una società digitale più equa, inclusiva e sostenibile. In questa prospettiva, l’educazione civica assume un ruolo centrale, fornendo ai cittadini gli strumenti concettuali e metodologici necessari per comprendere le implicazioni etiche, sociali e politiche delle tecnologie IA e per partecipare attivamente al dibattito pubblico in merito al loro sviluppo.

Amici, parlando di intelligenza artificiale e di come essa influenzi la nostra capacità di pensiero critico, è utile sapere che alla base di molti sistemi di IA c’è il concetto di “machine learning“. In parole semplici, il machine learning è un metodo che permette alle macchine di imparare dai dati senza essere esplicitamente programmate. Ad esempio, un algoritmo di machine learning può analizzare migliaia di articoli di notizie per imparare a distinguere tra quelli veri e quelli falsi.

E se volessimo qualcosa di più avanzato? Immaginate un sistema di IA che non solo impara dai dati, ma è anche in grado di spiegare il perché delle sue decisioni. Questo è ciò che si intende per “explainable AI” (XAI). Invece di una semplice risposta, otterremmo una spiegazione dettagliata, aiutandoci a capire meglio il processo decisionale della macchina e a fidarci di più (o meno) dei suoi risultati. Ma, pensandoci bene, non è forse questa la stessa cosa che cerchiamo di fare noi con il pensiero critico? Interrogarci, analizzare, capire il perché delle cose… Forse, alla fine, l’IA può essere uno strumento per affinare le nostre capacità, a patto di non dimenticare mai di usare la nostra testa.