L’alba di una nuova era nella scrittura creativa: l’intelligenza artificiale come strumento di espressione

Il settore dell’intelligenza artificiale è in piena effervescenza, con sviluppi che stanno rivoluzionando i limiti di ciò che si pensava possibile. OpenAI, un leader in questo campo, ha recentemente annunciato la creazione di un modello ChatGPT appositamente progettato per la scrittura creativa. Questo sistema promette di generare storie, componimenti poetici e copioni cinematografici con un livello di coerenza e di qualità tale da generare un acceso dibattito sul ruolo dell’IA nel mondo dell’arte e della cultura. Sam Altman, Amministratore Delegato di OpenAI, ha manifestato la sua sorpresa per l’originalità e la capacità inventiva dei testi prodotti da questa nuova IA, alimentando l’entusiasmo e sollevando interrogativi fondamentali sul futuro della scrittura.

Prompt per l’immagine: Un’immagine iconica che raffigura un cervello umano stilizzato, da cui germogliano rami fioriti che si trasformano in codice binario. Il codice binario si dissolve in una penna stilografica che fluttua su un mare di pixel. Lo stile dell’immagine dovrebbe essere ispirato all’arte naturalista e impressionista, con una palette di colori caldi e desaturati. Il cervello rappresenta la creatività umana, i rami fioriti simboleggiano la nascita di nuove idee, il codice binario rappresenta l’intelligenza artificiale e la penna stilografica rappresenta la scrittura. Il mare di pixel rappresenta il mondo digitale in cui tutto questo si manifesta. L’immagine non deve contenere testo.

La rivoluzione della comunicazione: dall’alfabeto agli avatar digitali

La comunicazione tra esseri umani è in perpetuo mutamento. Dai graffiti preistorici all’alfabeto, dall’invenzione della stampa di Gutenberg alla rete internet, ogni innovazione ha trasformato la nostra maniera di condividere concetti e conoscenze. Oggi, l’intelligenza artificiale sta aprendo nuovi scenari, con la prospettiva di rendere la comunicazione più immediata e coinvolgente. Victor Ripardelli, durante un suo intervento al TED, ha congetturato che i nostri successori potrebbero rappresentare l’ultima generazione ad essere in grado di leggere e scrivere nel modo in cui lo facciamo attualmente. L’IA, infatti, sta rendendo la creazione di video e audio sempre più accessibile e a basso costo, spianando la strada a contenuti creati in tempo reale, personalizzati e interattivi. Società come Synthesia stanno sviluppando repliche digitali capaci di interagire con milioni di individui in oltre 130 idiomi, offrendo nuove occasioni per l’istruzione, l’informazione e lo svago.

Scrivere con l’IA: una nuova forma di artigianato intellettuale

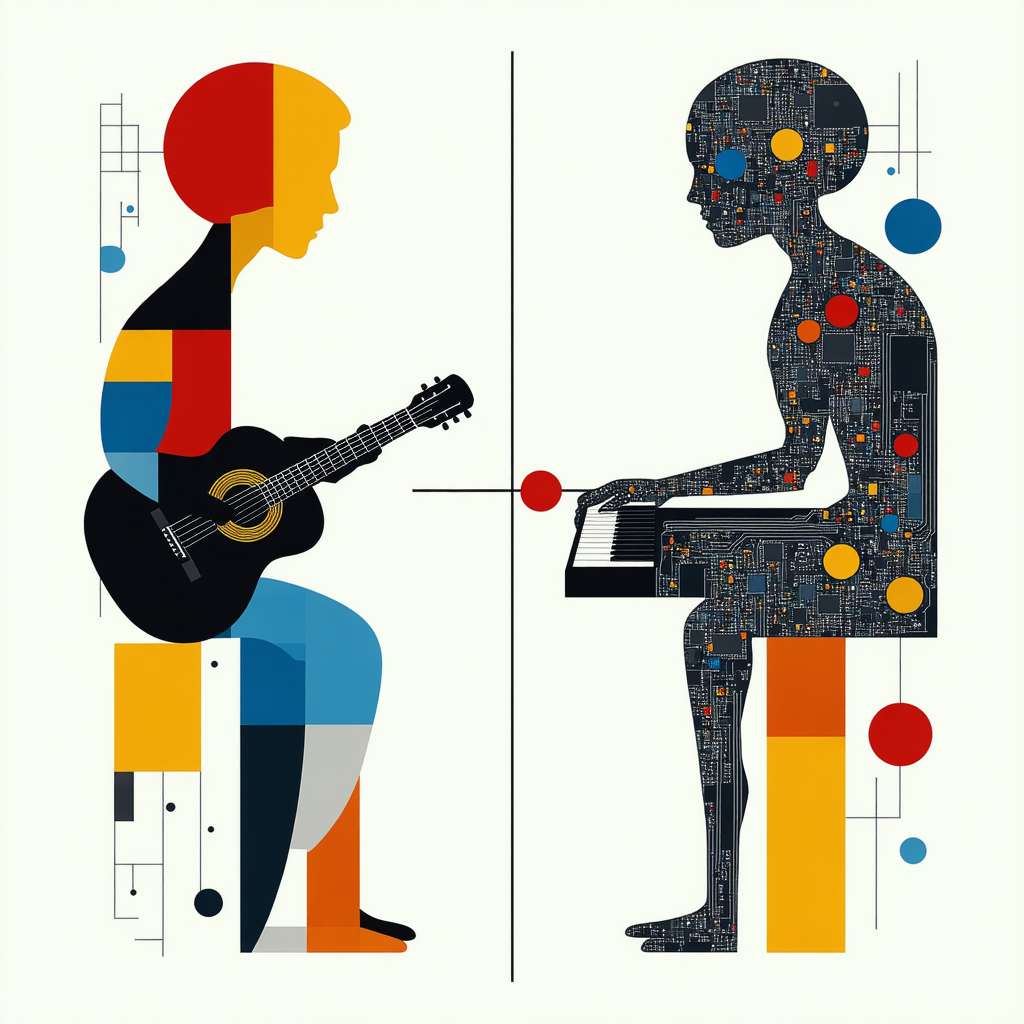

L’ingresso dell’IA nella scrittura non implica la fine della creatività umana, bensì l’inizio di una nuova epoca in cui l’intelligenza artificiale diventa uno strumento per potenziare le nostre capacità espressive. Contrariamente a quanto si potrebbe supporre, redigere testi con ChatGPT non è un’operazione completamente automatica. Richiede indicazioni ben definite, minuzie e perspicacia. L’IA non è una bacchetta magica che trasforma chiunque in uno scrittore di talento, ma piuttosto un mezzo che necessita competenza e abilità per essere adoperato in modo produttivo. Come evidenzia un premio letterario che esclude gli elaborati realizzati con l’IA, la vera difficoltà consiste nel comprendere l’essenza stessa della scrittura. La visione romantica della scrittura come ispirazione divina è ormai anacronistica. La scrittura è un’attività complessa che richiede metodo, rigore e una profonda padronanza del linguaggio. L’IA può rappresentare un valido collaboratore in questo percorso, assistendoci nel mettere ordine nei nostri pensieri, nell’esaminare nuovi punti di vista e nel perfezionare il nostro stile.

Oltre il testo: un futuro di esperienze comunicative immersive

Il futuro della comunicazione si preannuncia ricco di alternative. L’IA potrebbe trasformare radicalmente il nostro modo di apprendere, di lavorare e di divertirci.

*Provate ad immaginare di approfondire le vicende dell’antica Roma passeggiando virtualmente nel Colosseo, o di studiare la biologia osservando cellule in movimento in tempo reale attraverso riproduzioni interattive.

Dobbiamo ponderare la nostra relazione con le informazioni, la metodologia di apprendimento e persino il nostro concetto di individualità. Possiamo provare emozioni per figure completamente create artificialmente?

Riporremo fiducia in assistenti digitali al posto di esseri umani?

Quali ripercussioni deriveranno da un contesto in cui le nostre fattezze potranno essere duplicate a livello digitale?*

Verso un Rinascimento Digitale: l’IA come catalizzatore della creatività umana

In fin dei conti, l’intelligenza artificiale non rappresenta una minaccia per la creatività umana, ma un acceleratore che può permetterci di raggiungere livelli di espressione superiori. Come ogni strumento potente, l’IA deve essere impiegata con criterio e responsabilità, considerando le implicazioni etiche e sociali del suo utilizzo. Se saremo capaci di sfruttare il potenziale dell’IA in modo creativo e consapevole, potremo assistere a un vero e proprio Rinascimento Digitale, in cui l’arte, la scienza e la tecnologia si fondono per creare un futuro più ricco e stimolante per tutti.

Amici lettori, spero che questo viaggio nel mondo dell’intelligenza artificiale e della scrittura creativa vi abbia stimolato a riflettere sul futuro della comunicazione e sul ruolo dell’IA nella nostra società. Vorrei condividere con voi una nozione base di intelligenza artificiale che è fondamentale per comprendere il tema di questo articolo: il machine learning. Il machine learning è un tipo di intelligenza artificiale che permette ai computer di apprendere dai dati senza essere esplicitamente programmati. In altre parole, invece di scrivere un codice specifico per ogni possibile scenario, si forniscono al computer una grande quantità di dati e si lascia che impari a riconoscere i pattern e a fare previsioni. Nel caso della scrittura creativa, il machine learning viene utilizzato per addestrare i modelli di linguaggio a generare testi coerenti e creativi.

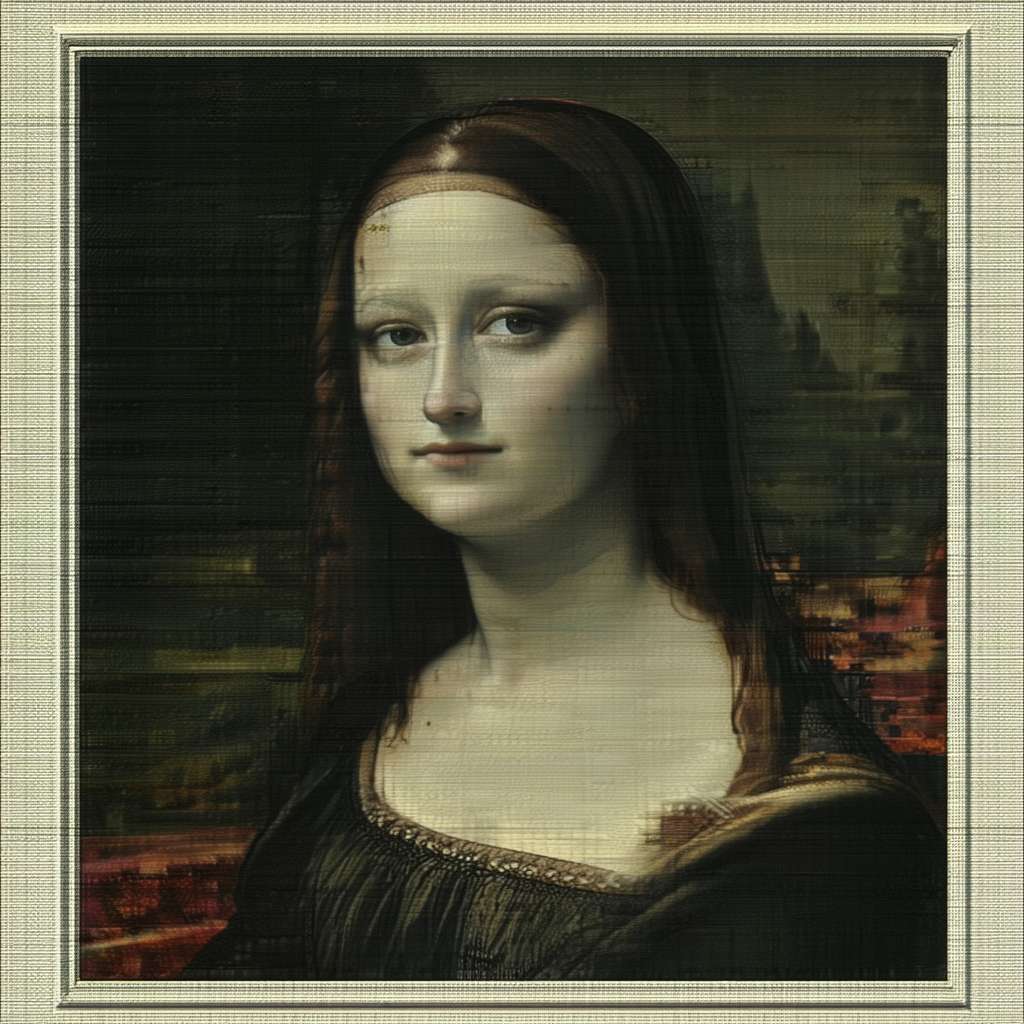

Una nozione più avanzata è quella delle reti neurali generative avversarie (GAN). Le GAN sono un tipo di architettura di machine learning che consiste in due reti neurali: un generatore e un discriminatore. Il generatore cerca di creare dati che sembrino reali, mentre il discriminatore cerca di distinguere tra i dati reali e quelli generati. Le due reti vengono addestrate in modo avversario, in cui il generatore cerca di ingannare il discriminatore e il discriminatore cerca di smascherare il generatore. Questo processo porta a un miglioramento continuo di entrambe le reti, e alla fine il generatore è in grado di creare dati che sono indistinguibili da quelli reali. Le GAN sono state utilizzate con successo per generare immagini, audio e testi realistici, e rappresentano una delle frontiere più promettenti dell’intelligenza artificiale creativa.

Vi invito a riflettere su come l’IA potrebbe trasformare il vostro modo di comunicare, di imparare e di creare. Quali sono le opportunità e le sfide che questa tecnologia ci presenta? Come possiamo assicurarci che l’IA venga utilizzata in modo etico e responsabile, per il bene di tutta l’umanità?