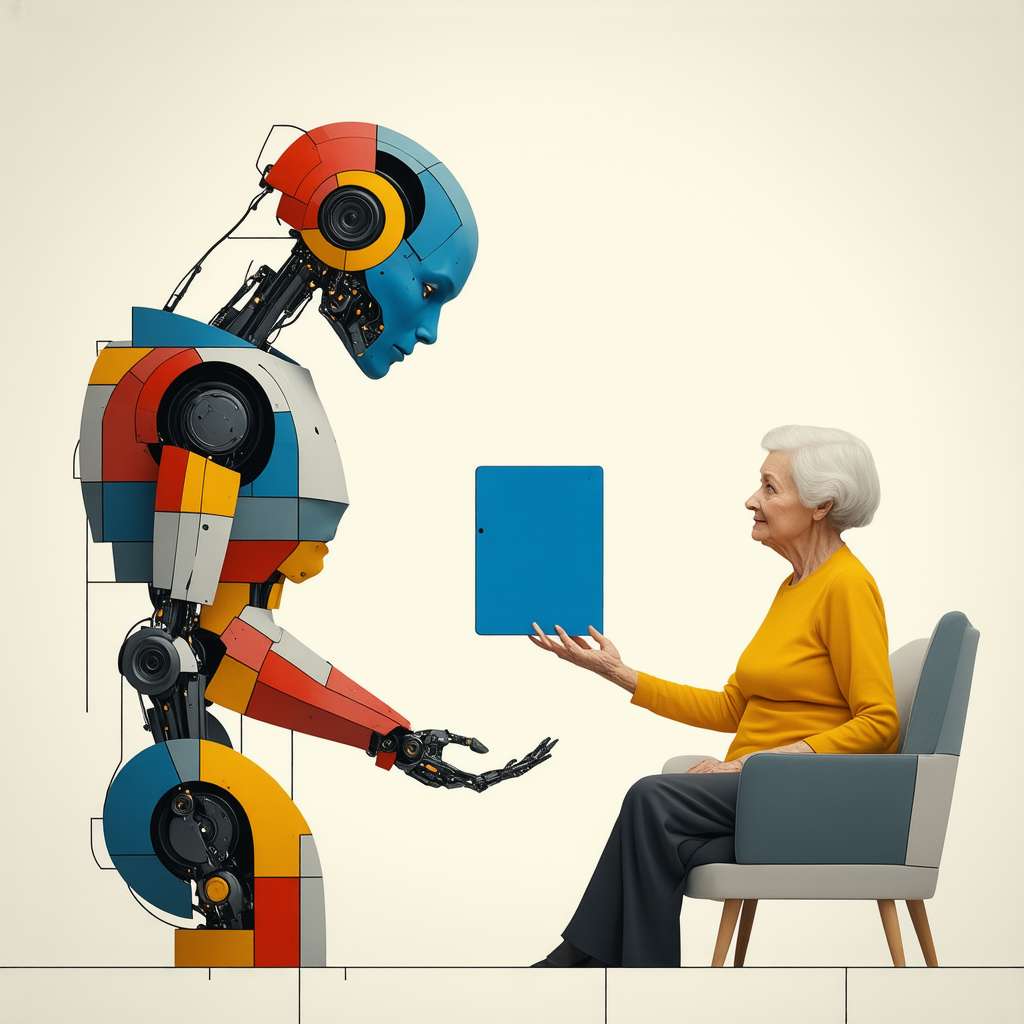

AI Studio segna una significativa evoluzione nell’assimilazione dell’intelligenza artificiale nel quotidiano degli individui. Attualmente in fase sperimentale riservata a specifici beta tester, questa innovativa funzione permette la facile realizzazione di chatbot personalizzati con una metodologia intuitiva priva della necessità di abilità informatiche avanzate. Attraverso un’interfaccia user-friendly, gli utenti possono modellare le caratteristiche distintive del loro assistente virtuale a partire dalla personalità, passando per il tono fino ad arrivare all’aspetto visivo.

L’elemento cruciale della personalizzazione è ciò che rende AI Studio straordinario: attraverso diverse opzioni disponibili, ciascun utente può determinare aspetti come lo stile comunicativo (che può oscillare fra ironia ed empatia) e scegliere un’immagine che ne rifletta l’identità visiva. Il risultato finale è immediatamente operativo: i chatbot sono inizialmente privati e accessibili esclusivamente ai loro ideatori; nonostante ciò, si presenta anche l’opportunità — mediante la creazione di link dedicati — di diffusione delle opere concepite. Questa abilità di condivisione amplia le opportunità per influencer, formatori e aziende, così come per i creatori digitali intenzionati a offrire contenuti o servizi automatizzati da prospettive fresche e innovative.

Sostituisci TOREPLACE con: “Create an iconic and symbolic image representing WhatsApp’s AI Studio. The image should feature a stylized speech bubble, representing communication, intertwined with a neural network pattern, symbolizing artificial intelligence. A customizable avatar icon should be subtly placed within the speech bubble, indicating personalization. The style should be inspired by naturalistic and impressionistic art, with a focus on warm, desaturated colors. The speech bubble should be depicted as a blooming flower, symbolizing growth and potential. The neural network should resemble a vine, subtly wrapping around the speech bubble, representing the interconnectedness of AI. The avatar icon should be a simple, abstract figure, suggesting the user’s ability to customize their AI assistant. The overall composition should be simple, unified, and easily understandable, with no text present.”

Condivisione degli Aggiornamenti di Stato: Maggiore Controllo e Visibilità

Contemporaneamente all’implementazione di AI Studio, il popolare servizio WhatsApp è impegnato nel collaudo di una novità riguardante i meccanismi per condividere gli aggiornamenti dello stato. Grazie a questa funzionalità innovativa, gli utenti avranno l’opportunità di fornire il proprio consenso alla ricondivisione e all’inoltro delle loro informazioni personali relative allo stato stesso, permettendo così un monitoraggio più dettagliato della propagazione del materiale condiviso.

Fino a oggi, infatti, le possibilità erano circoscritte ai soli contatti direttamente coinvolti o espressamente nominati nello status postato. Con quest’ultima evoluzione tecnologica proposta da WhatsApp, si aprono scenari nei quali sarà possibile optare affinché anche coloro che non sono stati direttamente contrassegnati possano trasmettere tale contenuto ad altri soggetti nella loro rete sociale. Tale funzionalità si rivela particolarmente vantaggiosa per quegli utenti intenzionati a estendere l’impatto comunicativo delle proprie creazioni ben oltre i confini della lista abituale dei contatti memorizzati: pensiamo alle necessarie promozioni commerciali oppure alle campagne sociali significative.

È importante sottolineare come, pur concedendo questa maggiore libertà nella condivisione degli stati tramite inoltri multipli, WhatsApp sottolinea che ciascun processo attinente al forwarding sarà effettuato in maniera riservata e tutelata da misure anonime adeguate: chi riceve lo stato riciclato infatti non disporrà dell’identificazione dell’autore originario né tantomeno potrà accedere al numero telefonico o all’immagine profilo del medesimo utilizzatore. Solo l’autore originario dello stato avrà il privilegio di ricevere una notifica quando uno dei suoi contatti decida di inoltrarlo. In aggiunta a ciò, se tale stato viene condiviso nuovamente da un altro utente, solo quest’ultimo sarà informato della ricondivisione, mentre l’autore originale non verrà notificato.

Un Futuro di Interazione Personalizzata e Condivisione Controllata

L’ingresso del sistema AI Studio, insieme alla sua innovativa funzionalità dedicata alla condivisione degli aggiornamenti statutari, rappresenta una vera e propria svolta per WhatsApp. La creazione di chatbot personalizzati, infatti, costituisce un passo avanti significativo nell’ambito dell’interazione umana attraverso le tecnologie digitali. Allo stesso tempo, il nuovo meccanismo che consente agli utenti un controllo dettagliato sulla privacy dei propri stati favorisce un utilizzo più consapevole della piattaforma. Attualmente in fase beta test, queste implementazioni sono destinate a modificare radicalmente l’esperienza del fruitore finale, avvicinando ulteriormente WhatsApp alle esigenze diversificate dei suoi utilizzatori globali. Il lancio dell’AI Studio si prevede su entrambi i sistemi operativi principali: Android e iOS.

Riflettiamo ora sull’importanza crescente dell’intelligenza artificiale nel quotidiano; essa è già presente sotto forma concreta attraverso NLP (Natural Language Processing), specializzazione cruciale dell’IA capace di interpretare ed elaborare il linguaggio umano da parte delle macchine. Immaginate se queste soluzioni chatbot fossero sviluppate ulteriormente utilizzando metodologie come il Reinforcement Learning: ciò permetterebbe loro non solo d’imparare a interagire meglio con gli esseri umani ma anche d’adattarsi proattivamente ai nostri comportamenti ed aspettative! Il futuro della comunicazione è qui, e sta bussando alla porta dei nostri smartphone.