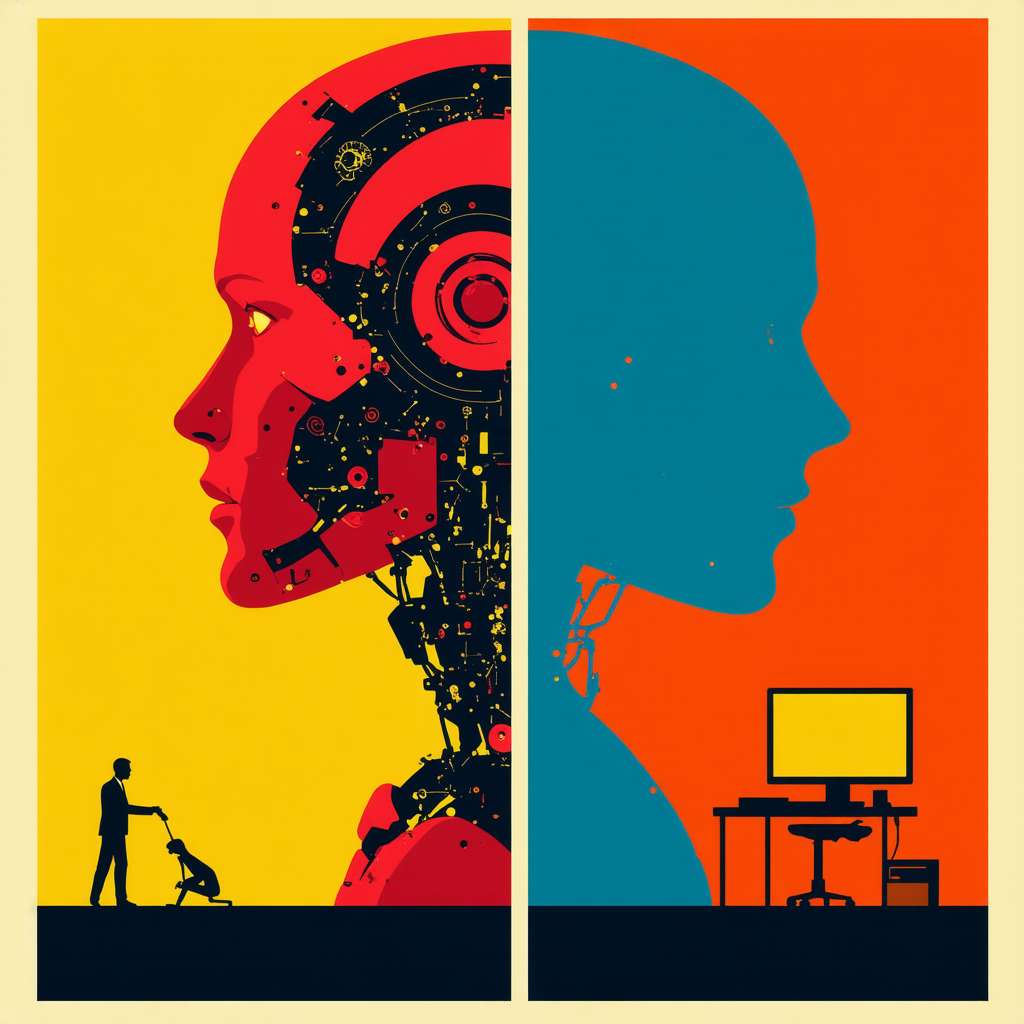

L’Unione Europea si trova oggi in una posizione complessa nel panorama globale dell’innovazione tecnologica. Mentre l’intelligenza artificiale (IA) rappresenta un potente motore di trasformazione economica, capace di rivoluzionare settori come il manifatturiero e la difesa, l’Europa sembra essersi auto-imbrigliata in una rete di regolamentazioni che ne rallentano lo sviluppo. Questo è stato evidenziato da Mario Draghi nel suo Rapporto sulla competitività europea del 2024, dove si sottolinea come il rigorismo fiscale e la sovra-regolamentazione stiano limitando la capacità dell’Europa di competere con potenze come gli Stati Uniti e la Cina.

Oltre oceano, l’intelligenza artificiale viene considerata un fattore chiave per la crescita economica e per questo motivo riceve significativo supporto finanziario e normative che ne promuovono lo sviluppo. In contrasto, l’Europa si trova a dover affrontare un sistema normativo complesso, dove il GDPR e l’AI Act impongono barriere che soffocano la competitività, in particolare per le piccole e medie imprese (PMI). Questo approccio difensivo ha portato a un ritardo significativo nell’adozione e nello sviluppo dell’IA, lasciando il campo libero ai concorrenti globali.

Il Summit di Parigi e le Tensioni Geopolitiche

Il recente Artificial Intelligence Action Summit di Parigi ha messo in luce le tensioni tra le principali potenze globali. Mentre 61 paesi, tra cui Francia, Germania e Cina, hanno firmato una dichiarazione congiunta per promuovere la collaborazione internazionale nell’IA, gli Stati Uniti e il Regno Unito si sono rifiutati di aderire. Il vicepresidente statunitense JD Vance ha espresso preoccupazioni riguardo ai limiti all’innovazione imposti dalla regolamentazione europea, mentre il governo britannico ha citato incertezze sulla governance globale.

La Cina, dal canto suo, ha dimostrato interesse per la cooperazione internazionale, come evidenziato dal successo del suo modello IA DeepSeek. Tuttavia, le tensioni con gli Stati Uniti rimangono alte, con Pechino che cerca di rafforzare il proprio controllo sulle tecnologie emergenti. Durante il summit, il presidente francese Emmanuel Macron ha annunciato un piano di investimenti da 109 miliardi di euro nell’IA, mentre la presidente della Commissione Europea ha promesso di raccogliere 200 miliardi di euro per sostenere l’innovazione in Europa.

Investimenti e Sfide per l’Europa

Nonostante gli annunci ambiziosi, la realtà degli investimenti nell’IA in Europa è complessa. Gran parte dei fondi promessi da Macron e dalla Commissione Europea dipendono dalla volontà del settore privato e dei partner internazionali di rispettare gli impegni presi. Un esempio vede il fondo d’investimento canadese Brookfield pianificare un supporto finanziario nell’ordine delle decine di miliardi, mentre il sostegno da parte degli Emirati Arabi Uniti potrebbe arrivare fino a una somma colossale.

Tuttavia, l’Europa si trova a fronteggiare una mancanza di giganti tecnologici paragonabili a OpenAI o Google, il che potrebbe portare le nuove infrastrutture IA a rimanere inutilizzate o sotto il controllo di grandi aziende già affermate. La proposta di un Cern dell’intelligenza artificiale potrebbe offrire una soluzione, creando un polo di ricerca indipendente che promuova l’innovazione senza pressioni commerciali.

Un Futuro Regolamentato ma Innovativo

La regolamentazione delle nuove tecnologie è una sfida complessa, ma l’Unione Europea deve trovare un equilibrio tra protezione dei diritti e promozione dell’innovazione. Le regole, come il GDPR, hanno dimostrato di funzionare, rendendo le aziende europee più resilienti e competitive. Tuttavia, è essenziale che l’Europa continui a investire in infrastrutture e politiche che favoriscano la crescita tecnologica.

In conclusione, l’Unione Europea deve abbracciare una visione che integri regolamentazione e innovazione. La storia ci insegna che le regole possono essere un’arma di competitività, ma è necessario un impegno continuo per migliorare l’esecuzione e l’enforcement a livello nazionale e comunitario.

Nel contesto dell’intelligenza artificiale, una nozione fondamentale è quella di machine learning, un sottoinsieme dell’IA che consente ai sistemi di apprendere e migliorare dalle esperienze senza essere esplicitamente programmati. Questo approccio è alla base di molte applicazioni moderne, dalla traduzione automatica alla diagnosi medica.

Un concetto avanzato correlato è il reinforcement learning, una tecnica di apprendimento automatico in cui un agente apprende a compiere decisioni ottimali attraverso prove ed errori, ricevendo feedback sotto forma di ricompense o penalità. Questa metodologia è particolarmente utile in scenari complessi, come la guida autonoma o la gestione delle risorse energetiche.

Riflettendo su questi concetti, è evidente che l’Europa deve trovare un modo per bilanciare la regolamentazione con l’innovazione, garantendo che le tecnologie emergenti siano sviluppate in modo etico e responsabile, ma senza soffocare il potenziale creativo e competitivo delle sue imprese.