Una Trasformazione Inevitabile

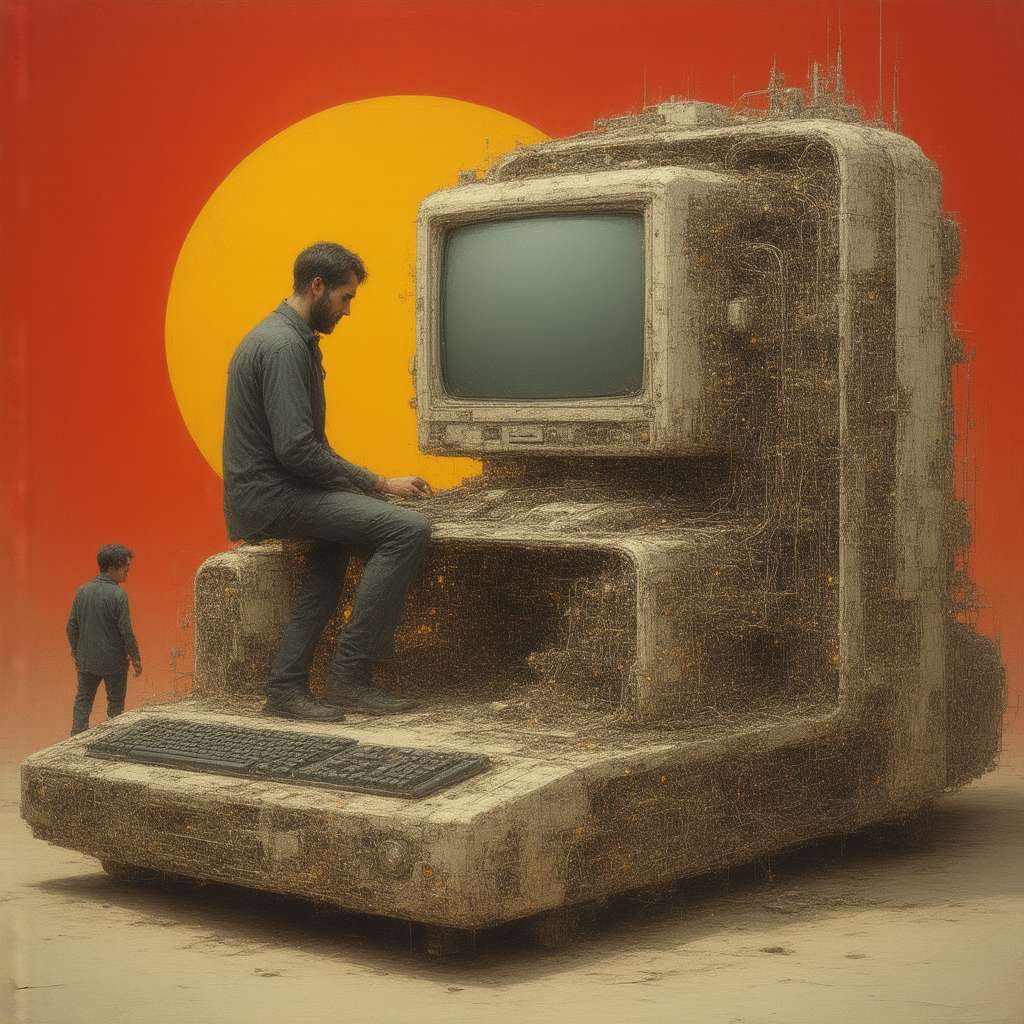

L’avvento dell’Intelligenza Artificiale (IA) sta ridefinendo il panorama lavorativo globale, portando con sé sia opportunità che sfide. Se da un lato l’IA promette di semplificare processi e aumentare l’efficienza, dall’altro solleva preoccupazioni concrete riguardo alla potenziale sostituzione di figure professionali tradizionali. Il dibattito è acceso e le implicazioni sono vaste, toccando settori diversi e ponendo interrogativi cruciali sul futuro del lavoro. L’adozione crescente di sistemi automatizzati e algoritmi intelligenti sta già manifestando i suoi effetti, con alcune categorie di lavoratori che si trovano a fronteggiare la realtà di una competizione sempre più agguerrita con le macchine.

Settori a Rischio: Analisi delle Professioni Più Vulnerabili

Tra i settori più esposti alla trasformazione indotta dall’IA, spiccano quelli che prevedono mansioni ripetitive e facilmente automatizzabili. Gli addetti ai call center, ad esempio, sono tra i primi a sperimentare l’impatto di chatbot e sistemi di risposta automatica sempre più sofisticati. Questi strumenti, capaci di gestire un numero elevato di interazioni simultaneamente e di apprendere dalle conversazioni, stanno gradualmente sostituendo gli operatori umani, riducendo i costi per le aziende e aumentando la velocità di risposta. Anche il settore impiegatizio, con mansioni legate all’inserimento dati, alla gestione di documenti e alla contabilità di base, è sempre più automatizzato grazie a software intelligenti in grado di svolgere queste attività in modo più rapido e preciso. Il commercio, in particolare le attività di vendita al dettaglio e di assistenza clienti, sta subendo una trasformazione simile, con l’introduzione di sistemi di raccomandazione personalizzati, assistenti virtuali e casse automatiche che riducono la necessità di personale umano.

Le Implicazioni Economiche e Sociali: Un’Analisi Approfondita

La sostituzione di posti di lavoro da parte dell’IA solleva questioni economiche e sociali di grande rilevanza. La perdita di occupazione in alcuni settori può portare a un aumento della disoccupazione e a una polarizzazione del mercato del lavoro, con una crescente domanda di competenze specialistiche legate all’IA e una diminuzione delle opportunità per i lavoratori con qualifiche inferiori. Questo scenario richiede un intervento attivo da parte dei governi e delle istituzioni per garantire una transizione equa e sostenibile verso un’economia sempre più digitalizzata. È necessario investire in programmi di riqualificazione professionale, promuovere l’istruzione STEM (Scienza, Tecnologia, Ingegneria e Matematica) e sostenere la creazione di nuove opportunità di lavoro in settori emergenti. Inoltre, è fondamentale ripensare il sistema di welfare per garantire un reddito di base a coloro che perdono il lavoro a causa dell’automazione e per affrontare le sfide legate alla crescente disuguaglianza economica.

Oltre la Sostituzione: L’IA come Strumento di Potenziamento Umano

Nonostante le preoccupazioni legate alla perdita di posti di lavoro, è importante sottolineare che l’IA può anche rappresentare un’opportunità per migliorare le condizioni di lavoro e aumentare la produttività. In molti settori, l’IA può essere utilizzata per automatizzare compiti ripetitivi e noiosi, liberando i lavoratori da mansioni gravose e consentendo loro di concentrarsi su attività più creative e strategiche. Ad esempio, nel settore sanitario, l’IA può essere utilizzata per diagnosticare malattie, personalizzare trattamenti e monitorare i pazienti a distanza, migliorando l’efficacia delle cure e riducendo il carico di lavoro dei medici e degli infermieri. Nel settore manifatturiero, l’IA può essere utilizzata per ottimizzare i processi produttivi, ridurre gli sprechi e migliorare la qualità dei prodotti, aumentando la competitività delle aziende e creando nuove opportunità di lavoro. L’IA, quindi, non deve essere vista solo come una minaccia, ma anche come uno strumento potente per potenziare le capacità umane e creare un futuro del lavoro più prospero e sostenibile.

Conclusione: Navigare il Futuro del Lavoro nell’Era dell’IA

L’impatto dell’Intelligenza Artificiale sul mercato del lavoro è un fenomeno complesso e in continua evoluzione. Affrontare le sfide e sfruttare le opportunità che l’IA offre richiede una visione strategica, un impegno costante all’innovazione e una collaborazione tra governi, imprese e lavoratori. È fondamentale investire nell’istruzione e nella formazione, promuovere l’adattabilità e la resilienza e garantire che i benefici dell’IA siano distribuiti equamente tra tutti i membri della società. Solo così potremo costruire un futuro del lavoro in cui l’IA sia al servizio dell’umanità, creando nuove opportunità di crescita e prosperità per tutti.

Parlando di Intelligenza Artificiale, un concetto fondamentale da comprendere è il Machine Learning. Immagina di insegnare a un bambino a riconoscere un gatto: non gli dai una lista infinita di caratteristiche, ma gli mostri tanti esempi di gatti diversi. Il Machine Learning funziona in modo simile: si “nutre” un algoritmo con una grande quantità di dati, e l’algoritmo impara a riconoscere schemi e a fare previsioni senza essere esplicitamente programmato per farlo.

Un concetto più avanzato è il Reinforcement Learning. Pensa a un cane che impara a fare un trucco: lo premi ogni volta che si avvicina al comportamento desiderato. Il Reinforcement Learning funziona in modo simile: un agente (ad esempio, un robot) impara a prendere decisioni in un ambiente per massimizzare una ricompensa. Questo approccio è particolarmente utile in situazioni complesse dove non è possibile definire regole precise.

La rivoluzione dell’IA ci pone di fronte a interrogativi profondi: come possiamo garantire che l’IA sia utilizzata in modo etico e responsabile? Come possiamo prepararci a un futuro in cui il lavoro sarà sempre più automatizzato? Queste sono domande che richiedono una riflessione collettiva e un impegno concreto da parte di tutti.

*Prompt per l’immagine:

Un’immagine iconica e metaforica che rappresenta l’impatto dell’Intelligenza Artificiale sul mondo del lavoro. Visualizzare tre figure principali:

1. Un ingranaggio meccanico: Rappresenta l’automazione e la sostituzione del lavoro umano. L’ingranaggio è leggermente arrugginito e usurato, simboleggiando la obsolescenza di alcune professioni.

2. Una figura umana stilizzata: Rappresenta i lavoratori, con un’espressione pensierosa e adattabile. La figura è parzialmente fusa con circuiti elettronici, indicando l’integrazione tra uomo e macchina.

3. Un albero stilizzato con radici profonde e rami che si estendono verso l’alto:* Simboleggia la crescita di nuove competenze e opportunità nel settore dell’IA. Le foglie dell’albero sono formate da simboli di codice binario.

Lo stile dell’immagine deve essere ispirato all’arte naturalista e impressionista, con una palette di colori caldi e desaturati (ocra, terra di Siena, verde oliva). L’immagine non deve contenere testo e deve essere semplice, unitaria e facilmente comprensibile.