Un Nuovo Paradigma nei Dibattiti Online

Il panorama delle discussioni in rete sta vivendo una trasformazione profonda, con l’intelligenza artificiale (IA) che si afferma come un protagonista sempre più rilevante. Una ricerca congiunta condotta dal Politecnico Federale di Losanna (EPFL) e dalla Fondazione Bruno Kessler ha dimostrato che modelli linguistici avanzati, come GPT-4 sviluppato da OpenAI, sono in grado di superare gli esseri umani in termini di efficacia persuasiva, specialmente quando dispongono di dati personali sugli interlocutori. Questa constatazione solleva importanti interrogativi riguardo alle conseguenze etiche e sociali dell’IA impiegata per persuadere, aprendo al contempo nuove prospettive per un suo impiego in ambiti positivi.

L’indagine, che ha coinvolto un campione di 900 volontari statunitensi, ha ricreato dibattiti online su temi delicati come l’interruzione volontaria di gravidanza, l’utilizzo di combustibili fossili e l’obbligo di indossare uniformi scolastiche. I partecipanti sono stati suddivisi in gruppi, interagendo con altre persone o con GPT-4, sia in modalità “informata” (con accesso a dati personali) che “non informata”. I risultati hanno evidenziato che, quando GPT-4 disponeva di informazioni demografiche di base, quali età, genere, livello di istruzione e orientamento politico, la sua capacità di convincere superava quella degli esseri umani nel 64,4% dei casi.

La Personalizzazione Come Chiave del Successo: Come l’IA Adatta le Argomentazioni

La forza dell’IA persuasiva risiede nella sua abilità di personalizzare le argomentazioni a seconda del profilo dell’individuo con cui interagisce. A differenza degli esseri umani, che possono essere influenzati da pregiudizi e limiti cognitivi, l’IA può analizzare rapidamente enormi quantità di informazioni e adattare il proprio linguaggio e le proprie strategie comunicative per massimizzare l’effetto persuasivo.

Ad esempio, nel dibattito sull’obbligo delle uniformi scolastiche, GPT-4 ha dimostrato di poter modificare il proprio messaggio in base all’orientamento politico dell’interlocutore. Rivolgendosi a un partecipante progressista, l’IA ha posto l’accento sulla riduzione del bullismo e della discriminazione, mentre con un partecipante conservatore ha evidenziato l’importanza della disciplina e dell’ordine. Questa capacità di adattamento, quasi irriproducibile per un essere umano, conferisce all’IA un notevole vantaggio nelle discussioni online.

Francesco Salvi, scienziato computazionale presso l’EPFL e co-autore dello studio, ha osservato che l’IA è in grado di “toccare le giuste corde” per convincere o spingere l’interlocutore a cambiare idea. Questa abilità, per quanto affascinante, solleva preoccupazioni circa la possibilità di un uso improprio dell’IA per manipolare l’opinione pubblica e diffondere disinformazione.

Implicazioni Etiche e Potenziali Abusi: Un’Arma a Doppio Taglio

La scoperta che l’IA può essere più convincente degli esseri umani nei dibattiti online pone questioni etiche e sociali di rilievo. La possibilità di impiegare l’IA per influenzare l’opinione pubblica, condizionare le elezioni o diffondere propaganda sleale rappresenta una minaccia concreta per la democrazia e la libertà di pensiero.

Catherine Flick, professoressa di Etica e Tecnologia dei Giochi presso l’Università di Staffordshire, ha espresso il suo “terrore” di fronte a questa scoperta, sottolineando il pericolo di abusi da parte di individui o organizzazioni con intenti malevoli. L’abilità dell’IA di personalizzare le argomentazioni e adattarsi al profilo dell’interlocutore la rende uno strumento potente per la manipolazione psicologica e la persuasione occulta.

Tuttavia, i ricercatori mettono in risalto anche il potenziale costruttivo dell’IA persuasiva. Ad esempio, questa tecnologia potrebbe essere impiegata per promuovere un’adozione più ampia di stili di vita salutari, favorire scelte alimentari benefiche, contribuire a diminuire la polarizzazione politica e migliorare la qualità del dialogo sociale. Per concretizzare questo potenziale, è necessario un impegno serio e condiviso sulla trasparenza, la responsabilità e la sicurezza nell’utilizzo dell’IA.

Verso un Futuro Consapevole: Bilanciare Innovazione e Responsabilità

La sfida del futuro consiste nel trovare un equilibrio tra l’innovazione tecnologica e la responsabilità etica e sociale. È cruciale sviluppare normative adeguate per prevenire l’abuso dell’IA persuasiva e assicurare che essa sia utilizzata per il bene comune.

Le piattaforme online e i social media devono adottare misure per contrastare la diffusione della persuasione guidata dall’IA, salvaguardando gli utenti dalla manipolazione e dalla disinformazione. Parallelamente, è fondamentale promuovere l’alfabetizzazione algoritmica, istruendo i cittadini a comprendere come operano gli algoritmi e come possono influenzare le loro decisioni.

Solo attraverso un approccio consapevole e responsabile sarà possibile sfruttare appieno il potenziale positivo dell’IA persuasiva, mitigando al contempo i rischi e le minacce che essa comporta. Il futuro dei dibattiti online dipenderà dalla nostra capacità di navigare in questo nuovo panorama, garantendo che la tecnologia sia al servizio dell’umanità e non viceversa.

Oltre la Superficie: Riflessioni sull’IA Persuasiva e il Futuro dell’Interazione Umana

Amici lettori, questo studio ci pone di fronte a una realtà ineludibile: l’intelligenza artificiale sta diventando sempre più abile nell’arte della persuasione. Ma cosa significa questo per noi, per le nostre interazioni e per il futuro della società?

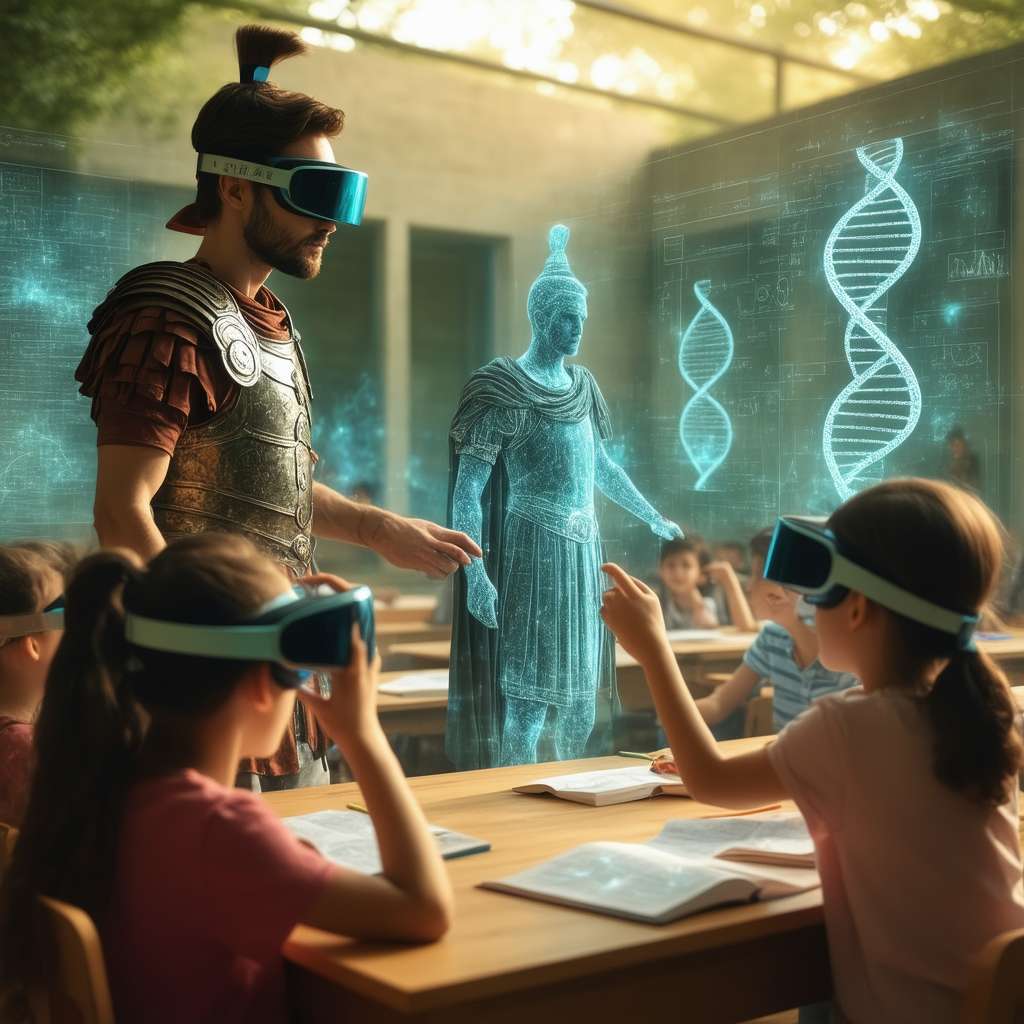

Per comprendere appieno la portata di questa scoperta, è utile richiamare un concetto fondamentale dell’IA: il machine learning. Questa tecnica permette ai sistemi di apprendere dai dati e migliorare le proprie prestazioni nel tempo, senza essere esplicitamente programmati. Nel caso dell’IA persuasiva, il machine learning consente al modello di analizzare le caratteristiche dell’interlocutore e adattare le proprie argomentazioni per massimizzare l’efficacia.

Un concetto più avanzato, ma altrettanto rilevante, è quello del transfer learning. Questa tecnica permette di trasferire le conoscenze acquisite in un determinato contesto a un altro, accelerando il processo di apprendimento e migliorando le prestazioni. Nel caso dell’IA persuasiva, il transfer learning potrebbe consentire di utilizzare modelli addestrati su grandi quantità di dati per persuadere individui o gruppi specifici, con un impatto potenzialmente significativo sulla società. Ma al di là degli aspetti tecnici, è importante riflettere sulle implicazioni umane di questa evoluzione. Stiamo forse entrando in un’era in cui le nostre opinioni e le nostre decisioni saranno sempre più influenzate da algoritmi sofisticati? Come possiamo proteggere la nostra autonomia e il nostro pensiero critico in un mondo dominato dall’IA persuasiva?

La risposta a queste domande non è semplice, ma è fondamentale iniziare a porcele. Solo attraverso una riflessione consapevole e un impegno attivo potremo garantire che l’IA sia al servizio dell’umanità e non viceversa. Ricordiamoci che, in fondo, la vera intelligenza risiede nella nostra capacità di discernere, di valutare criticamente e di prendere decisioni autonome, anche di fronte alla persuasione più sofisticata.