Ecco l’articolo in formato HTML:

Codex Cli: L’Open Source di OpenAI è Davvero Open? Un’Analisi del Controllo, della Community e del Futuro della Programmazione Ai

Cos’è Codex Cli?

Codex Cli si presenta come una svolta nel panorama dello sviluppo software, offrendo agli sviluppatori un’interfaccia a riga di comando (Cli) potenziata dall’intelligenza artificiale.

Immaginate di poter tradurre il linguaggio naturale direttamente in codice eseguibile, semplificando compiti complessi e riducendo drasticamente il tempo dedicato alla programmazione.

Questa è la promessa di Codex Cli, uno strumento che mira a democratizzare l’accesso alla programmazione, rendendola più intuitiva e accessibile anche a chi non possiede una conoscenza approfondita dei linguaggi di programmazione.

La sua peculiarità risiede nella capacità di interpretare comandi espressi in linguaggio naturale, convertendoli in istruzioni che il computer può eseguire.

Questo significa che, invece di dover ricordare sintassi complesse e comandi specifici, gli utenti possono semplicemente descrivere ciò che desiderano ottenere, e Codex Cli si occuperà di tradurre le loro intenzioni in codice funzionante.

Un esempio pratico potrebbe essere la creazione di uno script per automatizzare un processo ripetitivo: invece di scrivere manualmente ogni riga di codice, l’utente potrebbe semplicemente descrivere il processo in linguaggio naturale, e Codex Cli genererebbe lo script corrispondente.

Questa innovazione ha il potenziale di trasformare radicalmente il modo in cui gli sviluppatori interagiscono con i sistemi informatici, aprendo nuove frontiere nella programmazione assistita dall’intelligenza artificiale.

Tuttavia, dietro la facciata di strumento open source, si celano interrogativi importanti riguardo al reale grado di apertura e al controllo esercitato da OpenAI, la società che ha sviluppato Codex Cli.

È davvero uno strumento creato per la comunità, o una mossa strategica per raccogliere dati e affinare i modelli di intelligenza artificiale di OpenAI?

Il tool, secondo quanto riportato, supporta input multimodali, permettendo agli utenti di fornire screenshot o bozzetti insieme a prompt testuali, incrementando la sua versatilità nella gestione di diversi compiti di sviluppo.

Operando localmente, assicura che l’esecuzione del codice e le manipolazioni dei file avvengano all’interno del sistema dell’utente, proteggendo la privacy dei dati e riducendo la latenza.

Inoltre, Codex Cli offre livelli di autonomia configurabili tramite il flag –approval-mode, consentendo agli utenti di controllare l’estensione delle azioni automatizzate, che vanno dalla sola modalità di suggerimento alle modalità di approvazione automatica completa.

In definitiva, la vera rivoluzione promessa da Codex Cli risiede nella sua capacità di astrarre la complessità della programmazione, rendendola accessibile a un pubblico più ampio.

Immaginate un futuro in cui chiunque possa creare applicazioni e automatizzare processi senza dover necessariamente essere un esperto di programmazione.

Questo è il potenziale di Codex Cli, uno strumento che potrebbe davvero cambiare il volto dello sviluppo software.

Il dilemma dell’open source

La presentazione di Codex Cli come progetto open source solleva un dibattito cruciale: quanto è autenticamente “open” questa iniziativa?

Nonostante la definizione di “open source” implichi libertà di accesso, modifica e distribuzione del software, è fondamentale analizzare attentamente i termini e le condizioni che regolano l’utilizzo di Codex Cli.

In questo contesto, la licenza di utilizzo assume un ruolo centrale.

La licenza è il contratto legale che definisce i diritti e gli obblighi degli utenti nei confronti del software.

Una licenza open source “genuina”, come la MIT, Apache o GPL, concede agli utenti un’ampia libertà di utilizzo, modifica e distribuzione del codice, spesso con poche restrizioni. Tuttavia, alcune licenze, pur definendosi “open source”, possono imporre limitazioni significative, come restrizioni sull’utilizzo commerciale, obblighi di condivisione delle modifiche o divieti di utilizzo in determinati contesti.

Nel caso di Codex Cli, la mancanza di informazioni chiare sulla licenza solleva interrogativi legittimi.

Se la licenza non fosse una licenza open source standard, o se contenesse restrizioni significative, il grado di apertura del progetto sarebbe compromesso.

Gli utenti potrebbero trovarsi limitati nella loro capacità di utilizzare, modificare e distribuire il software, vanificando di fatto la promessa di “open source”.

Un altro aspetto da considerare è il controllo esercitato da OpenAI sul progetto.

Anche se il codice sorgente è disponibile pubblicamente, chi decide quali modifiche vengono accettate e integrate nel progetto?

OpenAI mantiene l’ultima parola sulle decisioni chiave relative allo sviluppo di Codex Cli?

Se OpenAI esercitasse un controllo eccessivo sul progetto, la comunità degli sviluppatori potrebbe sentirsi espropriata del proprio contributo, riducendo l’entusiasmo e la partecipazione.

Inoltre, è importante valutare il coinvolgimento della community nello sviluppo di Codex Cli.

Quanti sviluppatori esterni contribuiscono attivamente al codice?

OpenAI incoraggia e facilita i contributi della community? Come vengono gestite le segnalazioni di bug e le proposte di miglioramento? Un progetto open source sano e vitale si basa sulla partecipazione attiva di una comunità diversificata di sviluppatori, che collaborano per migliorare il software e adattarlo alle proprie esigenze.

In definitiva, la questione se Codex Cli sia veramente open source o meno dipende da una serie di fattori interconnessi: la licenza di utilizzo, il controllo esercitato da OpenAI e il coinvolgimento della community. Un’analisi approfondita di questi aspetti è essenziale per valutare il reale grado di apertura del progetto e le sue implicazioni per il futuro della programmazione assistita dall’intelligenza artificiale.

Community e controllo: un equilibrio delicato

Il successo di un progetto open source dipende intrinsecamente dalla sua comunità.

Una comunità attiva, motivata e inclusiva è il motore che alimenta l’innovazione, la correzione di bug e l’adattamento del software alle diverse esigenze degli utenti.

Tuttavia, la gestione di una comunità open source non è un compito semplice.

È necessario trovare un equilibrio delicato tra l’apertura ai contributi esterni e la necessità di mantenere una direzione coerente per il progetto.

Nel caso di Codex Cli, il ruolo di OpenAI nel controllo del progetto è un aspetto cruciale da considerare.

OpenAI, in quanto creatore originale del software, detiene inevitabilmente un certo livello di influenza sulle decisioni relative allo sviluppo.

La domanda è: quanto controllo esercita effettivamente OpenAI, e come questo controllo influisce sulla capacità della comunità di partecipare attivamente al progetto?

Un controllo eccessivo da parte di OpenAI potrebbe soffocare l’iniziativa della comunità, scoraggiando i contributi esterni e limitando la diversità delle prospettive.

D’altra parte, una mancanza di controllo potrebbe portare a un progetto frammentato, incoerente e difficile da mantenere. Trovare il giusto equilibrio è essenziale per garantire la vitalità e il successo a lungo termine di Codex Cli.

È importante valutare attentamente come OpenAI gestisce le segnalazioni di bug, le richieste di nuove funzionalità e i contributi di codice proposti dalla comunità.

Esiste un processo trasparente e inclusivo per la valutazione e l’integrazione dei contributi esterni?

OpenAI fornisce un feedback tempestivo e costruttivo ai membri della comunità?

Le risposte a queste domande possono fornire indicazioni preziose sul reale impegno di OpenAI nei confronti della comunità open source.

Inoltre, è fondamentale analizzare la governance del progetto.

Chi prende le decisioni chiave relative alla roadmap, all’architettura e alle funzionalità di Codex Cli?

La comunità ha un ruolo attivo nel processo decisionale, o le decisioni sono prese principalmente da OpenAI?

Un modello di governance trasparente e partecipativo può contribuire a rafforzare la fiducia della comunità e a promuovere un senso di ownership collettiva del progetto.

In definitiva, il futuro di Codex Cli dipenderà dalla capacità di OpenAI di coltivare una comunità attiva e coinvolta, garantendo al contempo un controllo adeguato per mantenere la coerenza e la qualità del progetto. Un equilibrio delicato tra community e controllo è la chiave per trasformare Codex Cli in un vero successo open source.

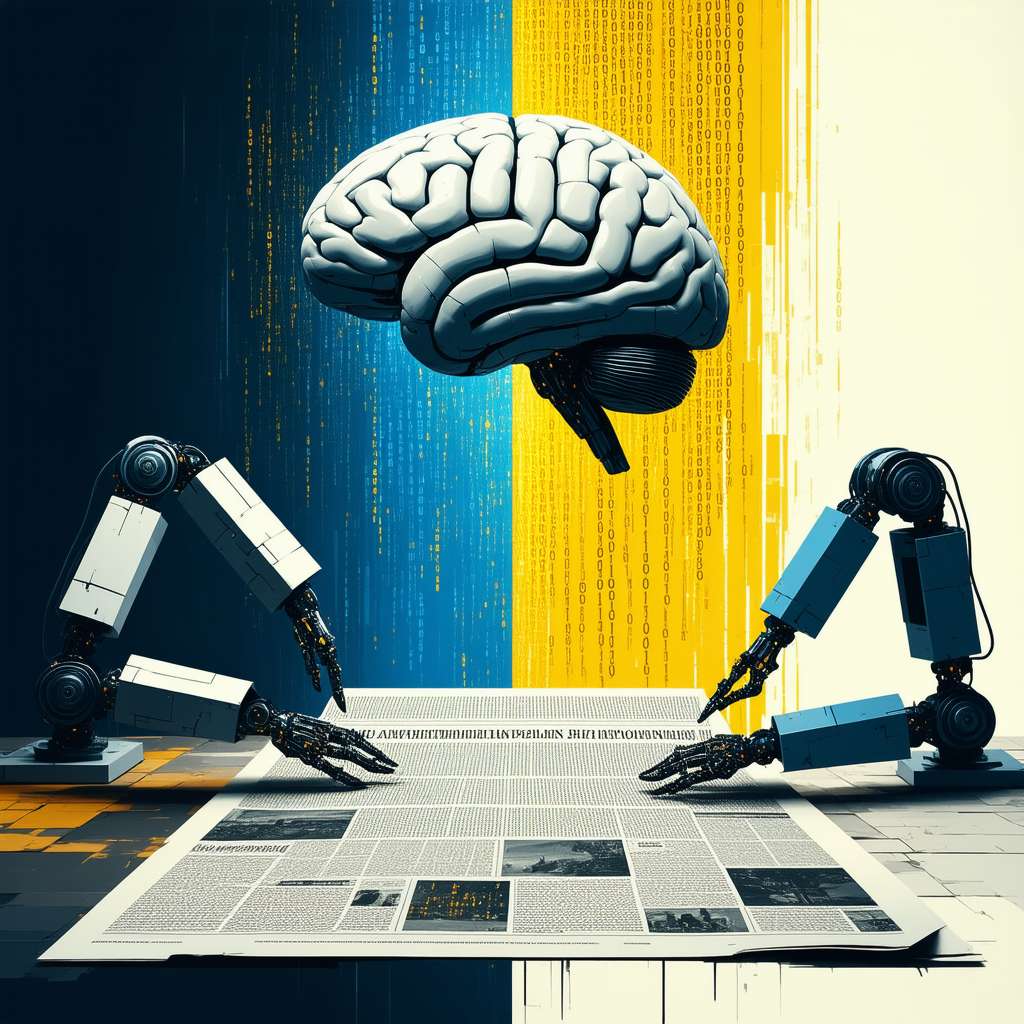

Verso un futuro di programmazione aumentata

L’avvento di Codex Cli rappresenta un tassello importante nel mosaico della programmazione aumentata, un paradigma in cui l’intelligenza artificiale collabora con gli sviluppatori per potenziare le loro capacità e accelerare il processo di sviluppo.

In questo scenario, l’intelligenza artificiale non sostituisce il programmatore, ma agisce come un assistente intelligente, in grado di automatizzare compiti ripetitivi, suggerire soluzioni innovative e rilevare errori nascosti.

Codex Cli, con la sua capacità di tradurre il linguaggio naturale in codice eseguibile, incarna perfettamente questa visione.

Gli sviluppatori possono utilizzare Codex Cli per esprimere le proprie idee in modo intuitivo, senza dover necessariamente conoscere la sintassi complessa dei linguaggi di programmazione.

L’intelligenza artificiale si occupa di tradurre queste idee in codice funzionante, liberando il programmatore da compiti tediosi e consentendogli di concentrarsi sugli aspetti più creativi e strategici del progetto.

Questo approccio ha il potenziale di democratizzare l’accesso alla programmazione, rendendola più accessibile a persone con diverse competenze e background.

Chiunque abbia un’idea per un’applicazione o un software potrebbe utilizzare strumenti come Codex Cli per trasformare la propria visione in realtà, anche senza essere un esperto di programmazione.

Questo potrebbe portare a un’esplosione di creatività e innovazione nel mondo dello sviluppo software, con un aumento significativo del numero di persone in grado di creare e condividere le proprie creazioni.

Tuttavia, è importante considerare anche i rischi potenziali associati alla programmazione aumentata.

L’affidamento eccessivo all’intelligenza artificiale potrebbe portare a una perdita di competenze e a una diminuzione della capacità dei programmatori di comprendere e controllare il codice che stanno generando. È fondamentale che gli sviluppatori mantengano un ruolo attivo nel processo di programmazione, utilizzando l’intelligenza artificiale come uno strumento per potenziare le proprie capacità, piuttosto che come un sostituto.

Inoltre, è necessario affrontare le questioni etiche e sociali legate all’utilizzo dell’intelligenza artificiale nella programmazione. Come possiamo garantire che gli algoritmi di intelligenza artificiale utilizzati in Codex Cli siano equi, trasparenti e privi di bias?

Come possiamo proteggere la privacy degli utenti e prevenire l’utilizzo improprio dei dati raccolti da questi strumenti? Queste sono domande importanti che devono essere affrontate per garantire che la programmazione aumentata sia utilizzata in modo responsabile e a beneficio di tutta la società.

In definitiva, il futuro della programmazione è destinato a essere sempre più intrecciato con l’intelligenza artificiale.

Strumenti come Codex Cli rappresentano un passo avanti significativo verso un mondo in cui la programmazione è più accessibile, intuitiva e potente.

Tuttavia, è fondamentale affrontare le sfide e i rischi associati a questa trasformazione per garantire che la programmazione aumentata sia utilizzata in modo responsabile e a vantaggio di tutti.

Riflessioni sull’innovazione e sull’etica

Codex Cli, con la sua promessa di semplificare la programmazione e democratizzare l’accesso al codice, ci pone di fronte a interrogativi profondi sul futuro dello sviluppo software e sul ruolo dell’intelligenza artificiale nella nostra società.

Oltre alle questioni tecniche e legali relative alla licenza open source e al controllo del progetto, è importante considerare le implicazioni più ampie di questa innovazione.

Come cambierà il lavoro dei programmatori con l’avvento di strumenti come Codex Cli? Assisteremo a una trasformazione del ruolo del programmatore, da creatore di codice a supervisore di algoritmi? Quali nuove competenze saranno necessarie per affrontare le sfide della programmazione aumentata?

Queste sono domande che meritano una riflessione approfondita, per prepararsi al meglio al futuro del lavoro nel settore IT.

Inoltre, è fondamentale considerare l’impatto sociale di Codex Cli.

Se la programmazione diventa più accessibile e intuitiva, quali nuove opportunità si apriranno per persone provenienti da contesti diversi? Assisteremo a una maggiore diversità nel mondo dello sviluppo software, con un aumento della partecipazione di donne, minoranze e persone con disabilità?

Codex Cli potrebbe contribuire a ridurre il divario digitale e a creare una società più inclusiva e equa?

Tuttavia, è anche importante essere consapevoli dei rischi potenziali.

La democratizzazione dell’accesso alla programmazione potrebbe portare a un aumento della produzione di software di bassa qualità o addirittura dannoso?

Come possiamo garantire che le persone utilizzino Codex Cli in modo responsabile e etico, evitando di creare software che diffonda disinformazione, discrimini o violi la privacy degli utenti?

L’etica e la responsabilità devono essere al centro di qualsiasi discussione sull’innovazione tecnologica, per garantire che il progresso sia al servizio del bene comune.

In definitiva, Codex Cli ci invita a riflettere sul significato di “apertura” e “controllo” nell’era dell’intelligenza artificiale.

È possibile conciliare la libertà di accesso e la collaborazione con la necessità di garantire la qualità, la sicurezza e l’etica del software?

La risposta a questa domanda determinerà il futuro della programmazione e il ruolo dell’intelligenza artificiale nella nostra società.

A proposito di intelligenza artificiale, un concetto base fondamentale è l’apprendimento automatico, o machine learning. Si tratta della capacità di un sistema di apprendere da dati senza essere esplicitamente programmato. Nel caso di Codex CLI, l’apprendimento automatico permette al sistema di “capire” il linguaggio naturale e tradurlo in codice.

Un concetto più avanzato è il transfer learning. Invece di addestrare un modello da zero, il transfer learning permette di utilizzare un modello pre-addestrato su un vasto dataset (come il modello linguistico di OpenAI) e adattarlo a un compito specifico (come la traduzione del linguaggio naturale in codice). Questo riduce notevolmente il tempo e le risorse necessarie per l’addestramento.

In fondo, l’innovazione tecnologica ci pone sempre di fronte a delle scelte. Come esseri umani, abbiamo la responsabilità di indirizzare queste innovazioni verso un futuro che sia non solo efficiente, ma anche etico e inclusivo.