Analisi del curriculum formativo: è in linea con le richieste del mercato del lavoro AI?

Il bando vIvA, promosso dal Fondo per la Repubblica Digitale in collaborazione con Google.org, si propone di affrontare una sfida cruciale nel panorama contemporaneo: il disallineamento tra le competenze offerte dai percorsi formativi e quelle effettivamente richieste dal mercato del lavoro nell’ambito dell’Intelligenza Artificiale. Con uno stanziamento di 2,6 milioni di euro, l’iniziativa punta a formare figure professionali capaci di inserirsi con successo nel mondo del lavoro, con particolare attenzione alle fasce di popolazione più vulnerabili. Tuttavia, la domanda cruciale rimane: il curriculum formativo proposto è realmente in grado di rispondere alle esigenze di un settore in continua evoluzione come quello dell’IA?

Per rispondere a questa domanda, è necessario analizzare attentamente i contenuti dei corsi offerti, verificando se essi coprono le aree chiave dell’IA, quali il machine learning, il deep learning, l’elaborazione del linguaggio naturale e la visione artificiale. È fondamentale, inoltre, valutare se i formatori possiedono un’esperienza concreta nel settore e se i materiali didattici sono aggiornati e in linea con le ultime tendenze tecnologiche. Un’indagine condotta da Michael Page ha evidenziato che le aziende del settore ricercano professionisti con una solida base tecnica, ma anche con competenze trasversali, quali la capacità di gestire progetti complessi, di risolvere problemi in modo creativo e di lavorare in team.

Le competenze trasversali, spesso definite soft skills, sono sempre più richieste dalle aziende, poiché permettono ai professionisti di adattarsi ai cambiamenti, di comunicare efficacemente e di collaborare con successo in ambienti multidisciplinari. Un altro aspetto cruciale da considerare è la comprensione delle implicazioni etiche dell’IA, un tema sempre più rilevante in un mondo in cui gli algoritmi influenzano sempre più aspetti della nostra vita. I professionisti dell’IA devono essere consapevoli dei rischi di bias e discriminazioni insiti negli algoritmi e devono essere in grado di progettare sistemi che siano equi, trasparenti e responsabili.

Inoltre, è importante valutare se il curriculum formativo del bando vIvA prevede moduli specifici dedicati allo sviluppo di queste competenze trasversali e alla comprensione delle implicazioni etiche dell’IA. La sola conoscenza tecnica, pur essendo fondamentale, non è sufficiente per garantire il successo nel mondo del lavoro. I professionisti dell’IA devono essere in grado di applicare le proprie conoscenze in modo responsabile e consapevole, tenendo conto dell’impatto che le loro decisioni possono avere sulla società. Un curriculum formativo completo e ben strutturato deve, quindi, integrare le competenze tecniche con le competenze trasversali e la comprensione delle implicazioni etiche dell’IA, al fine di formare professionisti capaci di affrontare le sfide del futuro.

Focus sulle persone vulnerabili: quali sono le barriere concrete?

Il bando vIvA si pone un obiettivo ambizioso: favorire l’inclusione nel mondo del lavoro nel campo dell’Intelligenza Artificiale (IA) delle persone che si trovano in condizioni di vulnerabilità. Tuttavia, la strada verso questo traguardo è lastricata di ostacoli concreti, che rischiano di compromettere il successo dell’iniziativa. Il digital divide, inteso come disparità nell’accesso alle tecnologie digitali e alla connettività internet, rappresenta una barriera significativa per molte persone vulnerabili. Secondo i dati del rapporto Auditel-Censis, circa il 10% delle famiglie italiane non ha accesso a Internet, mentre un ulteriore 30% si connette esclusivamente tramite smartphone. Questa situazione di esclusione digitale impedisce a molte persone di partecipare ai corsi di formazione online e di acquisire le competenze necessarie per inserirsi nel mercato del lavoro dell’IA.

Un altro ostacolo importante è rappresentato dalle competenze pregresse. Molte persone vulnerabili non possiedono le competenze di base necessarie per affrontare un corso di formazione avanzato in IA. La mancanza di familiarità con l’uso del computer, con i software e con i concetti matematici di base può rendere difficile l’apprendimento e scoraggiare la partecipazione. È fondamentale, quindi, che il bando vIvA preveda dei moduli introduttivi che colmino queste lacune e forniscano ai partecipanti le basi necessarie per affrontare il percorso formativo.

Le barriere non si limitano solo all’ambito digitale. Molte persone vulnerabili affrontano anche difficoltà di tipo economico, sociale e culturale che possono ostacolare il loro accesso al mondo del lavoro. La mancanza di risorse economiche, la discriminazione, la scarsa istruzione e la mancanza di reti sociali di supporto possono rendere difficile la ricerca di un impiego e l’inserimento in un ambiente lavorativo competitivo. Il bando vIvA deve, quindi, tenere conto di queste problematiche e prevedere delle misure di sostegno che aiutino le persone vulnerabili a superare questi ostacoli.

Un approccio efficace per affrontare queste barriere consiste nel fornire ai partecipanti un sostegno personalizzato, che tenga conto delle loro esigenze specifiche e delle loro difficoltà individuali. Questo sostegno può includere attività di orientamento*, di *mentoring*, di *tutoraggio* e di *assistenza nella ricerca di un impiego*. È importante, inoltre, che il bando *vIvA promuova la creazione di reti sociali di supporto, che permettano ai partecipanti di condividere esperienze, di scambiarsi consigli e di sostenersi a vicenda. In questo modo, sarà possibile creare un ambiente inclusivo e accogliente, che favorisca la partecipazione e il successo di tutte le persone, indipendentemente dalla loro condizione di vulnerabilità.

Indagine sulle aziende: sono disposte ad assumere personale formato tramite vIvA?

L’efficacia del bando vIvA non si misura solamente dalla qualità della formazione offerta, ma anche dalla concreta possibilità per i partecipanti di trovare un impiego nel settore dell’Intelligenza Artificiale. Un aspetto cruciale, quindi, è quello di verificare se le aziende sono disposte ad assumere personale formato tramite questa iniziativa e quali sono le loro aspettative in termini di competenze e professionalità.

Un’indagine condotta da Michael Page ha evidenziato che le aziende del settore IA ricercano professionisti con una solida base tecnica, ma anche con competenze trasversali, quali la capacità di gestire progetti complessi, di risolvere problemi in modo creativo e di lavorare in team. Inoltre, le aziende apprezzano i candidati che dimostrano una forte motivazione, una grande capacità di apprendimento e una predisposizione all’innovazione. È fondamentale, quindi, che il bando vIvA prepari i partecipanti non solo dal punto di vista tecnico, ma anche dal punto di vista personale e professionale, fornendo loro gli strumenti necessari per affrontare con successo il mondo del lavoro.

Le aziende sono sempre più consapevoli dell’importanza dell’inclusione e della diversità nel mondo del lavoro. Molte aziende, infatti, si impegnano attivamente per creare ambienti inclusivi e accoglienti, che valorizzino le differenze e offrano pari opportunità a tutti. Il bando vIvA può rappresentare un’opportunità per le aziende di dimostrare il loro impegno per l’inclusione, assumendo personale formato tramite questa iniziativa e contribuendo a creare un mercato del lavoro più equo e inclusivo.

Tuttavia, è importante che le aziende siano consapevoli delle difficoltà che possono incontrare le persone vulnerabili e che siano disposte ad offrire loro un sostegno adeguato. Questo sostegno può includere attività di formazione sul posto di lavoro*, *programmi di mentoring* e *opportunità di crescita professionale. In questo modo, sarà possibile creare un ambiente lavorativo in cui tutti i dipendenti si sentano valorizzati e supportati, e in cui le persone vulnerabili possano esprimere al meglio il loro potenziale.

Inoltre, è importante che il bando vIvA promuova un dialogo costante tra i formatori e le aziende, al fine di allineare i contenuti dei corsi alle reali esigenze del mercato del lavoro. Questo dialogo può includere visite aziendali*, *seminari tenuti da esperti del settore* e *opportunità di stage e tirocinio. In questo modo, sarà possibile garantire che la formazione offerta dal bando vIvA sia sempre aggiornata e in linea con le ultime tendenze tecnologiche, e che i partecipanti siano preparati ad affrontare le sfide del futuro.

Verso un Futuro Inclusivo: Competenze, Opportunità e Sfide Etiche

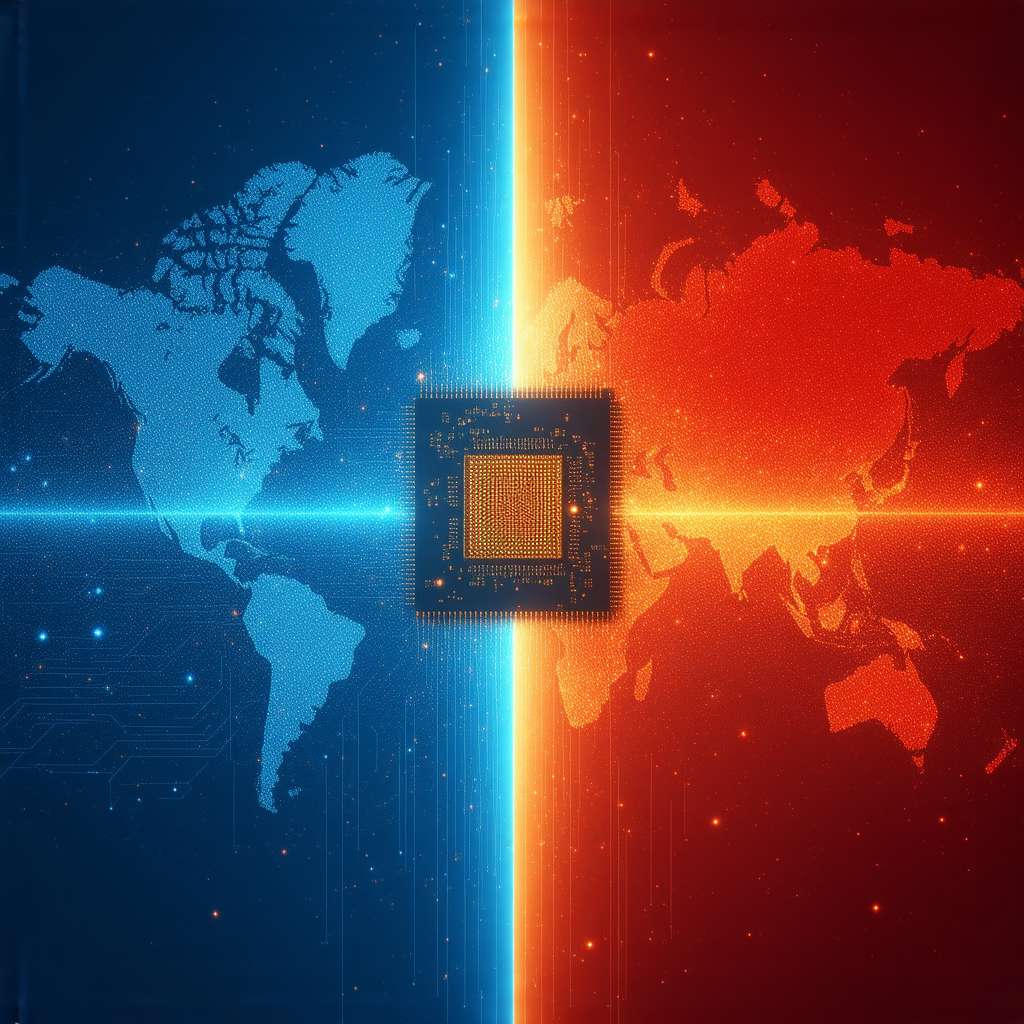

L’iniziativa del bando vIvA rappresenta un passo importante verso la creazione di un futuro più inclusivo nel settore dell’Intelligenza Artificiale. Tuttavia, il successo di questa iniziativa dipende dalla capacità di affrontare le sfide che si presentano e di sfruttare al meglio le opportunità che si aprono. È fondamentale, quindi, che tutti gli attori coinvolti, dalle istituzioni alle aziende, dai formatori ai partecipanti, collaborino attivamente per raggiungere questo obiettivo.

Le istituzioni devono impegnarsi a sostenere l’inclusione digitale, promuovendo l’accesso alle tecnologie digitali e alla connettività internet per tutte le persone, indipendentemente dalla loro condizione economica, sociale e culturale. Le aziende devono impegnarsi a creare ambienti lavorativi inclusivi e accoglienti, che valorizzino le differenze e offrano pari opportunità a tutti i dipendenti. I formatori devono impegnarsi a fornire una formazione di qualità, che tenga conto delle esigenze specifiche dei partecipanti e che li prepari ad affrontare con successo il mondo del lavoro. I partecipanti devono impegnarsi a sfruttare al meglio le opportunità offerte dal bando vIvA, acquisendo le competenze necessarie per inserirsi nel mercato del lavoro e contribuendo a creare un futuro più equo e inclusivo.

Il settore dell’Intelligenza Artificiale offre grandi opportunità di crescita e di sviluppo, ma presenta anche delle sfide etiche importanti. È fondamentale, quindi, che tutti i professionisti del settore siano consapevoli di queste sfide e si impegnino a progettare e sviluppare sistemi di IA che siano equi, trasparenti e responsabili. Solo in questo modo sarà possibile garantire che l’IA sia al servizio dell’umanità e che contribuisca a creare un futuro migliore per tutti.

L’Intelligenza Artificiale, nel contesto di questo articolo, si può definire come la capacità di un sistema informatico di svolgere compiti che richiedono normalmente l’intelligenza umana, come l’apprendimento, il ragionamento, la risoluzione di problemi e la comprensione del linguaggio naturale. Ma attenzione, qui entra in gioco anche un concetto più avanzato: l’AI spiegabile (XAI). Questa branca dell’IA si concentra sullo sviluppo di modelli e algoritmi che non solo raggiungono un’elevata accuratezza, ma che sono anche comprensibili e interpretabili dagli esseri umani. Immagina di poter capire esattamente perché un algoritmo ha preso una determinata decisione. Questo è particolarmente cruciale quando l’IA viene utilizzata in contesti sensibili, come la selezione del personale o la valutazione del rischio, dove è essenziale garantire l’equità e la trasparenza delle decisioni.

Ecco perché riflettere sul bando vIvA e sulle sue potenzialità è un esercizio di responsabilità civica. Non si tratta solo di formare persone, ma di costruire un futuro in cui la tecnologia sia uno strumento di inclusione e non di esclusione. Un futuro in cui le competenze digitali siano accessibili a tutti, indipendentemente dalla loro condizione di partenza, e in cui l’Intelligenza Artificiale sia uno strumento per migliorare la vita di ogni persona.